空間演出ユニットhuez「3.5次元のライブ演出」第七回(前編)

キズナアイ、ピーナッツくん、KEIJUの事例から解説 バーチャルライブ制作における「Unity」と「Unreal Engine」の違いって?

テクノロジーの進化に伴い発展するライブ演出。この潮流のなかで特異な存在感を示すのが、「フレームの変更」をコンセプトに掲げる空間演出ユニット・huez(ヒューズ)だ。ライブ演出における“ヴィジュアル”と “光”の専門家が集まるユニットで、アーティストの物語に寄り添った演出を得意とする。

本連載「3.5次元のライブ演出」ではhuezのメンバーを迎え、先端技術のその先にあるライブ体験の本質的なキー概念について、具体的な演出事例を交えながら解き明かしていく。第7回の前編となる今回は、変化を続けるhuezの転換期ともいえる2021年の仕事を振り返りつつ、本年の取り組みについて語ってもらった。

自社の知見を集合した企画『Serial experiments huez』

ーー前回のインタビュー記事掲載以後のhuezの取り組みとしては、『Serial experiments huez』と題されたhuezの自主企画イベントが興味深い取り組みです。こちらはどのような経緯で始まったのでしょうか。

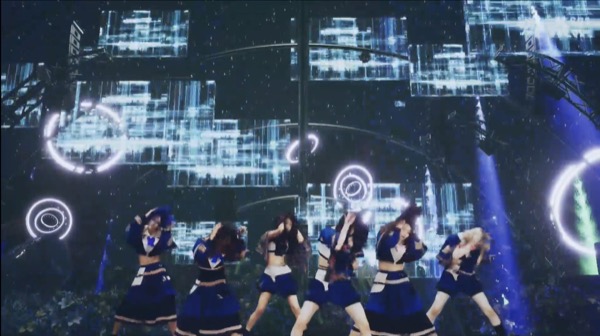

ayafuji(アヤフジ):まず、僕が普段参加しているXRライブの多くは Moment Tokyo、REZ&、huezを中心としたXRプロダクションチームで、数々のXRライブを制作しています。この『Serial experiments huez』はそのなかでも特殊で、huez一社で作っていて、社内メンバーのCGに対する知見を深め、リアルライブの知見を活かす目的で企画したものでした。

社内でアサインされたのが普段はリアルライブを中心に手掛けているメンバーだったので、Unreal EngineやBlenderなど、CG作成に必要なソフトウェア技術のキャッチアップから入ったんですよ。

ーーある種、社内スタッフの教育的な観点もあったということですか。

ayafuji:そうですね。リアルライブの知見を持っている僕らが「新しい試みとして、XRライブをやったらどうなるんだろう」という思いがあったんです。ワクワクとドキドキを胸に、取り組んでいきました(笑)。

ーーこの企画は生身の人間がXRライブに出演するというものでしたが、苦労したことや注力した点はありますか。

ayafuji:苦労したことで言うと、リアルライブは客席ありきでいろんな角度から観るのに対して、XRライブだと究極的にはある瞬間にひとつの視点しかない、という点です。それぞれの演出に沿ったカメラワークの提案や調整をしていくのが大変でしたね。加えて、リアルライブとXRライブでは開発方法も全く異なっています。リアルライブの場合は要所にセンサーを使ったりと、一部分の領域に対してテクニカルな開発を行うイメージですが、XRライブだとUnreal Engineのようなソフトウェアをベースに展開していくわけです。こうした違いから来る差分を埋めるためにスタッフは苦労していました。

ーー前回の取材で印象に残っているのが、「仮想空間でライブを打つのは3Dゲームを一本作るようなものだ」という言葉です。

ayafuji:正確に言うと規模や開発期間の点で異なりますが、僕はゲームを「ルールの集合体」として捉えていて、自由度の高い空間の中にどういうルールを設けるのか。これはXRライブを作るときにもとても重要なことです。どういったコンセプトを骨にするのかを決めて、1本線を引いていくのが難しいところですね。

ーー『Serial experiments huez』を終えて、次につながる学びはありましたか。

ayafuji:いやあ、もうたくさんありましたね(笑)。開発体制を作っていくうえで、どんなワークフローが最適なのか決めるのも手探りでしたし、またリアルライブを経験しているからこその難しさも感じました。XRライブって、スケジュール感がリアルライブとはまったく違うんです。なのにライブというゴール自体は定まっているから、そこに向かって取り組むのは苦労した点ですね。「この日までには演出内容を見れるようにしておかなきゃ」だとか、そういう期限がリアルライブに比べて短い。

ーーリアルライブに比べて、具体的にどのくらい前倒しになるんですか。

ayafuji:極端なことを言えば、1週間くらい前には演出内容が出来上がっているイメージです。そこから、いわゆる“バグ取り期間”があるんです。ライブ演出でありながらソフトウェア開発の側面を持っているので、本番直前にパラメータなどをいじってしまうと、ソフトウェアが不安定になる恐れがあります。リアルライブの場合はむしろ逆で、事前にプランを作ったうえで実際の現場に行き、レーザーや照明、映像などを現地で見ながらディレクターが最終調整をかけてクオリティを高めていくので、この違いには苦しめられました。

ーー1週間前にはつるっとライブを1本見られるような状態にして、そこからバグ取りが始まるわけですね。

ayafuji:僕が関わらせてもらったのが、テクニカルの監督と、とくにソフトウェア開発で、フレームレートなどソフトウェアのリソースを管理もするポジションです。特にフレームレートは非常に奥が深くて……。フレームレートは1秒間に何回画面を更新できるか(fps)、という指標なんですが、たとえばあまりに大きい4Kのテクスチャを使っていると、そこのオブジェクトを表示するスピードが変わる(フレームレートが落ちる)ので、解像度を調整する必要があります。この辺りの微妙なさじ加減やバランスの持たせ方は、僕がテクニカルアーティストとして行う仕事の真骨頂であり、「美術」と「技術」の領域が重なっている部分なんです。

ーーアートとして成立させ、なおかつポリゴン数や解像度をテクニカルな視点から判断していくわけですね。

ayafuji:ディレクターの意向やコンセプトを把握しながら、CGアーティストやバーチャルカメラを置くカメラマンに指示出しを行って折衝していく仕事です。逆にこちらから「このタイミングでこの仕組みやシステムを使えば、面白い演出になるのでやりましょう」と提案していくこともありますね。

ーーバグ取り中に、「これを取ったらバランスが崩れる」みたいなことって起こるのでしょうか。

ayafuji:そうならないように意識はしています。直前に変えようとするとそういうことが起きやすい。また、それぞれの仕組みが緩く依存し合っていたりすると、ある箇所のバグを修正した際に別のところが代わりにおかしくなってしまったりということもあります。