3Dアバターがより身近な存在に? 『SIGGRAPH 2025』で発表された最新のAI技術たち

衣服の3Dオブジェクトやインテリアデザイン3Dシーンの生成を実現

スイス連邦工科大学ローザンヌ校らの研究チームは、1人の人間を撮影した1枚の画像から、その人間が着用していた衣服の3Dオブジェクトを生成するAIモデルを発表した(※6)。このAIはTシャツのようなタイトな衣服から、スカートのようなゆったりとした衣服まで、そのデザインを正確に再現する。

なお、以上のAIは細かいシワのある衣服については、その再現度に限界がある。また、入力する画像は全身が写っている画像でなければならない、という制限事項もある。将来的には、衣服の時間的変化に対応した3D動画生成モデルの開発を目指している。

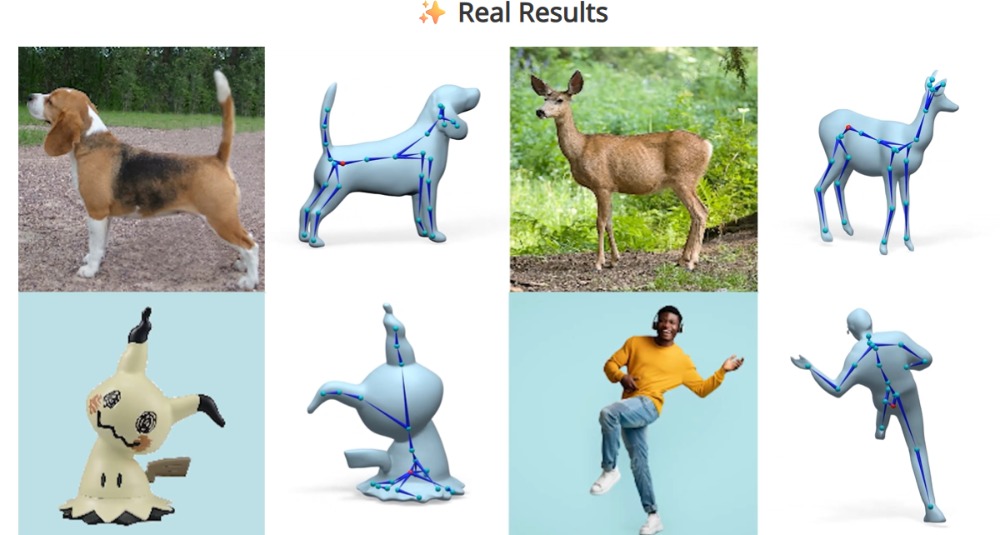

カリフォルニア大学サンディエゴ校とAdobeらの研究チームは、3Dオブジェクトを入力すると、リグが追加されたオブジェクトを生成する「RigAnything」を発表した(※7)。リグとは3Dオブジェクトを動かす際の仕組みのことであり、通常はこの仕組みを追加する「リギング」作業をすることによって、3Dオブジェクトを動かして3Dアニメーションを制作できる。

リグを追加するAIモデルは以前から存在しているが、RigAnythingは従来モデルより高速なリグ生成を実現した。その速度は従来比で20倍であり、あらゆるリグ生成を2秒以内に実行する。また、ヒト型、四足動物、海洋生物、昆虫といった多様な関節構造の3Dオブジェクトのリグ生成にも対応する。

アメリカ・スタンフォード大学とNVIDIAらの研究チームは、多様なインテリアデザイン3Dシーンを生成する「ReStyle3D」を発表した(※8)。このAIは、ベースとなるさまざまな調度品が置かれた2D画像と、視点移動可能な屋内3Dシーン動画を入力情報として受け付ける。これらを入力すると、2D画像に3Dシーン動画のインテリアデザインを反映したうえで、2D画像を3Dシーン動画に変換する。わかりやすく言えば、2D画像のインテリアデザインを変えて3Dシーン化するのだ。

ただし「ReStyle3D」には、入力する2D画像と3Dシーン動画におけるそれぞれの照明設定が著しく異なると、期待される3Dシーン動画が生成されないなどの制限事項がある。

以上に紹介したAIは、衣服の3Dオブジェクト生成、3Dオブジェクトのリグ生成、インテリアデザイン3Dシーン動画生成のような明確な使用用途を意図したうえで開発されている。こうしたAIは、早晩クリエイターが使うことになるだろう。

動画内のオブジェクト挿入やストーリーボードからのアニメーション生成に成功

香港大学とAlibabaらの研究チームは、動画のなかに任意の動くオブジェクトを追加したり、動画内のオブジェクトをほかのオブジェクトに置換したりできる「VideoAnydoor」を発表した(※9)。このAIを活用すれば、例えば海を撮影した動画に飛んでいるカモメを挿入できる。

挿入するオブジェクトは静止画で指定でき、動作はオブジェクト内に動くポイントを指定したうえで、そのポイントを動かすことで動作の軌跡を設定できる。

「VideoAnydoor」の具体的な応用には、人間を撮影した動画において衣服を置換するバーチャル試着や、任意の動画内に映っているオブジェクトへのロゴ挿入などが想定されている。

イギリス・エディンバラ大学と写真共有アプリ『Snapchat』を開発・運営するSnapらの研究チームは、簡単な2Dストーリーボードから3Dアニメーションを生成する「Sketch2Anim」を発表した(※10)。

ストーリーボードとは、アニメや実写映画において重要となるシーンをイラスト等で図解して、ストーリーの流れを伝えるものである。「Sketch2Anim」の場合、棒人間とその動きを示す線だけで構成されたストーリーボードを入力すれば、事前に用意していた3Dキャラクターの動きを生成できる。キャラクターを詳細に描き込んだストーリーボードも、入力情報として活用できる。

「Sketch2Anim」を進化させる方向性には、2通りある。1つめは、動きのスピードを表現するスピードラインにも対応する方向である。2つめは、生成されるアニメーションの環境としてテーブルなどのオブジェクトを配置できるようにして、キャラクターと周囲のオブジェクトの相互作用を考慮した動きを生成できるようにする方向だ。

以上に紹介した10本の論文からわかるように、グラフィックAIはCGの下位カテゴリーとしてではなく、CG全体に溶け込んで、いわば“下支え”をする要素・技術になりつつある。今後はグラフィックAIがますますCGと混然一体となって、CGにAIが使われていることがあまり意識されなくなるのではないだろうか。

〈参考〉

(※1)「Style Customization of Text-to-Vector Generation with Image Diffusion Priors」https://customsvg.github.io/

(※2)「Efficient Line Art COlorization with BRoAder References」https://zhuang2002.github.io/Cobra/

(※3)「IP-Prompter: Training-Free Theme-Specific Image Generation via Dynamic Visual Prompting」https://ip-prompter.github.io/

(※4)「Text-based Animatable 3D Avatars with Morphable Model Alignment」https://onethousandwu.com/animportrait3d.github.io/

(※5)「LAM: Large Avatar Model for One-shot Animatable Gaussian Head」https://aigc3d.github.io/projects/LAM/

(※6)「Single View Garment Reconstruction Using Diffusion Mapping Via Pattern Coordinates」https://liren2515.github.io/page/dmap/dmap.html

(※7)「RigAnything: Template-Free Autoregressive Rigging for Diverse 3D Assets」https://www.liuisabella.com/RigAnything/

(※8)「Scene-level Appearance Transfer with Semantic Correspondences」https://restyle3d.github.io/

(※9)「VideoAnydoor : High-fidelity Video Object Insertion with Precise Motion Control」https://videoanydoor.github.io/

(※10)「Sketch2Anim: Towards Transferring Sketch Storyboards into 3D Animation」https://zhongleilz.github.io/Sketch2Anim/

アメリカでは1550億ドル以上の投資も AIを巡る国際競争の現在地を整理する

近年の生成AIの動向は、テック業界におけるトピックのひとつであることを超えて、各国の経済や国際競争にも影響を及ぼしている。日本や…