人類は“緩やかなシンギュラリティ”に突入した? AGIの実現に関する現状と課題

76%の専門家が「現状の技術でAGIの実現は困難」と回答

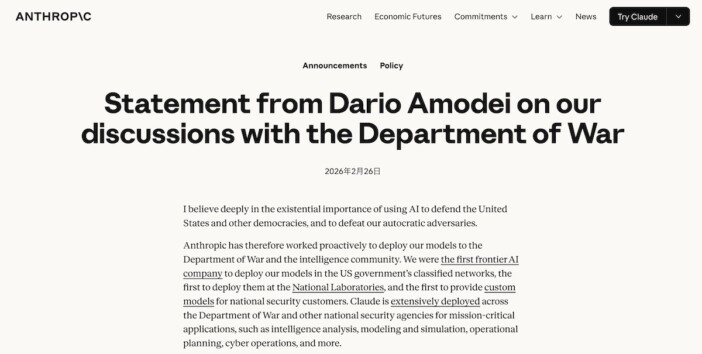

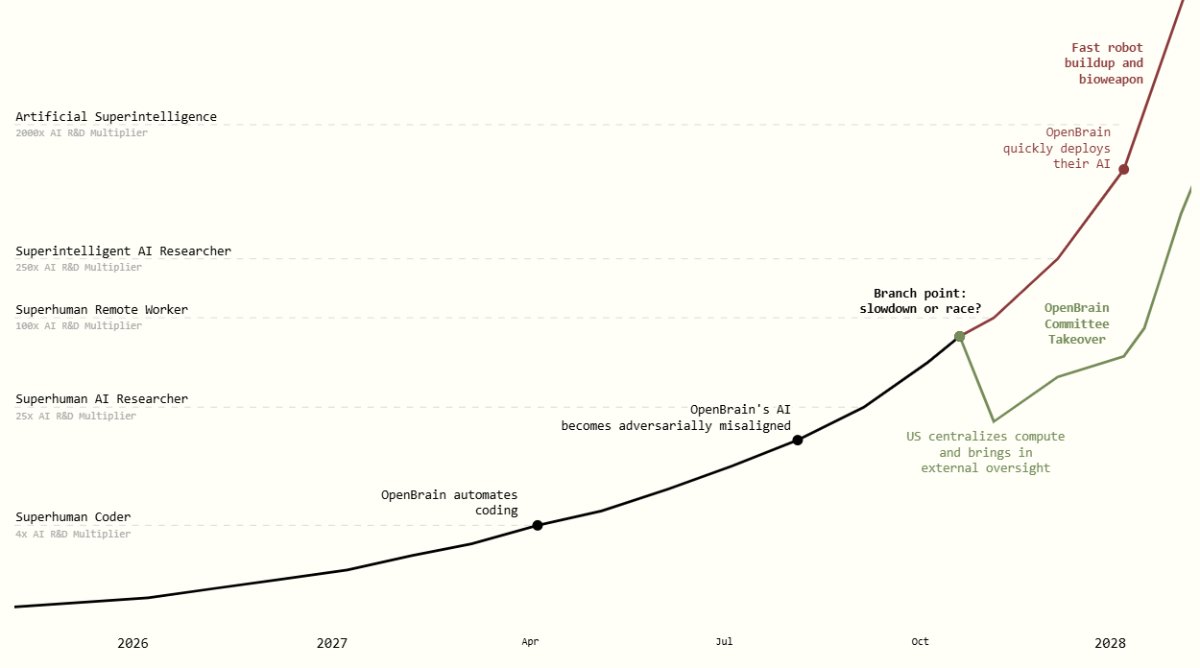

アルトマン氏と『AI 2027』は、2020年代にAGIが誕生すると予想している。その一方で(まさに『AI 2027』のなかで予想されたように)、専門家たちはAGIの実現を疑問視しているのが実情だ。

2025年3月、AIの推進を目的としたアメリカの学会「AAAI(Association for the Advancement of Artificial Intelligence:AI推進のための協会)」は、さまざまなAIの課題に関する専門家の意見をまとめたレポートを発表した(※3)。

アメリカだけではなくアジアやヨーロッパで活動するAI研究者475名を対象にアンケート調査を実施した以上のレポートでは、AGIの実現可能性に関する質問も行われている。具体的には「現在のAIアプローチを拡大してAGIを実現できるか」という質問に対して、76%の回答者が「成功する可能性は低い」または「非常に低い」と答えた。専門家たちは、AGI実現のためには現状では存在しない“新たなAI開発技術”が必要だと考えているのだ。

AIのリスク評価を専門とするAI研究者のボルハネ・ブリリ・ハメリン(Borhane Blili-Hamelin)氏が筆頭執筆者を務めた論文「“AGI”をAI研究の北極星として扱うのは止めよう」では、AI研究においてAGIの実現を目標とすること自体に対して疑義を呈している(※4)。

ハメリン氏らの論文では、AGIをAI研究の目標に設定すると“6つの罠”に陥ると説いている。そうした罠にはAGIの定義が曖昧にもかかわらず、その意味が共有されているような錯覚に陥る「コンセンサスの錯覚」、研究の意義を学術的動機ではなく経済的動機に見出してしまう、つまりは“成功すれば物凄く儲かる”から研究する「宝くじ的ゴール」といったものがある。

以上のような罠を考察したうえで、ハメリン氏らはAGIの定義を明確にするなどの健全なAI研究に関する3つの提言を表明している。

AGIの実現可能性に関しては、アルトマン氏や『AI 2027』のようにその実現を言わば既定路線のように考えるグループがある一方で、AGIの実現を疑問視するグループも存在しており、両者のあいだでは言わば拮抗状態が続いている。

AGIは人間の言うことを聞くのか?

AGIに関しては、それが技術的に実現可能かどうかを議論する工学的な問いかけのほかに、仮にそれが実現できたとして、人間が制御可能などうかを議論する問いかけもある。こうした問いかけは、AGIの「アライメント問題」と総称される。

以上の問題については、アメリカ・シンシナティ大学電気コンピューター工学部のアリ・A・ミナイ(Ali A. Minai)教授が2025年5月に論文を発表している(※5)。この論文でははじめに、AIのトレンドが生成AIからAIエージェントに移り変わっていることを取り上げ、AIがより自律性を高める方向に進化していることを確認している。

上記のAI進化の傾向をふまえると、AGIが誕生した場合、それはデータセンターに鎮座するようなものではなく、自由に場所を変えて至る所にアクセスできる存在となると考えられる。そのようなものを完全に制御下に置くのは極めて困難、とミナイ教授は結論づけている。

ドイツのフリードリヒ・アレクサンダー大学の博士課程でAI哲学を研究するマックス・ヘルリゲル=ホルダバウム(Max Hellrigel-Holderbaum)氏らが2025年6月に発表した論文は、AIを人間にとって望ましいように動作させる技術である「AIアライメント」のリスクを指摘している(※6)。

この技術は、『ChatGPT』をはじめとする現在普及している対話型AIにも使われているが、ホルダバウム氏らによれば、AIアライメントを悪用すれば、AIが悪事を働くように訓練することも可能となるという。したがって、AIアライメント自体は、必ずしもAGIの安全性を保障するものではない。この技術が、AGIを悪用する手段にもなり得るからだ。

以上のようなAGIのアライメント問題を論じた論文を参照した限りでは、AGIを技術的に実現できたとしても、その制御は極めて困難と言わざるを得ない。そうであるならば、「制御困難なAGIは開発しないほうがいいのではないか」という倫理的立場から、AGI反対論が唱えられるようになるかもしれない。

本稿では、2025年時点におけるAGIの実現可能性を多角的に見てきた。そうして見えてきたのは、AGIの実現をかたく信じているAIビジネス業界のグループと、その実現性に疑義を呈している学会のグループが言わば拮抗状態を成していることであった。そして、時代の流れは、AGI推進派のほうがわずかに押しているようにも見える。

こうしたAGI実現への流れが今後さらに大きくなった場合、AIアライメントの立場からこの流れに異議を唱える立場が注目される可能性もあるだろう。

AGIにまつわる議論は、高度に抽象的かつ専門性が高い“面倒くさい”話である。しかしながら、この話は同時に全人類に関わる重大事でもある。このような話には、本稿が試みているような“話を整理する”役回りが今後とも不可欠となるだろう。

〈参考〉

(※1)Sam Altman「The Gentle Singularity」:https://blog.samaltman.com/the-gentle-singularity

(※2)AI fututes Project「AI 2027」:https://ai-2027.com/

(※3)AAAI「AAAI 2025 Presidential Panel on the Future of AI Research」:https://aaai.org/about-aaai/presidential-panel-on-the-future-of-ai-research/

(※4)arXiv「Stop treating `AGI' as the north-star goal of AI research」:https://arxiv.org/abs/2502.03689

(※5)arXiv「Position Paper: Bounded Alignment: What (Not) To Expect From AGI Agents」:https://arxiv.org/abs/2505.11866?utm_source=chatgpt.com

(※6)arXiv「Misalignment or misuse? The AGI alignment tradeoff」:https://www.arxiv.org/abs/2506.03755?utm_source=chatgpt.com

波紋を呼んだYouTubeの収益化ポリシー更新 「オリジナル」「本物」追求の“真”の目的とは

「YouTube パートナー プログラム(YPP)」収益化ポリシー更新の発表を受けてその内容をおさらいしながら、YouTubeの…