米津玄師のARライブを成功に導いた“テクノロジーとクリエイティブ” 制作チームに聞くプロジェクトの舞台裏

東京・東急プラザ原宿「ハラカド」にて、8月15日から8月25日の間で開催されたARライブイベント「LOST CORNER AR LIVE in HARAKADO」。これは米津玄師の最新アルバム『LOST CORNER』の発売を記念して行われたものだ。

舞台となった東急プラザ原宿「ハラカド」から、向かいの東急プラザ表参道「オモカド」や原宿交差点、ラフォーレ原宿など周辺の建物の形状を活かしたARライブでのパフォーマンスは、ファン以外にも多くのクリエイター、関係者から称賛されている。筆者もそのひとりで、ARライブとしては最高峰のものを目撃した、と断言できる。

そこで今回は、このARライブを制作したWhatever Co./SoVeCという2つのチームに取材。Whateverからはプロデューサーの渡辺綾子氏、テクニカルディレクターの登山元気氏、アートディレクター/デザイナーの高谷優偉氏、テクニカルアーティスト/VFXアーティストの衣袋宏輝氏に、SoVeCからは代表取締役社長の上川衛氏、ソニー株式会社の技術開発研究所にも所属しているテクニカルディレクターの高山裕也氏、企画・戦略 シニアマネージャーの吉原早紀氏の計7名に、今回のプロジェクトの舞台裏について、じっくりと話を聞いた。(編集部)

アーティストの意思・クリエイターの力・実現するための技術が噛み合って生まれた“極上のARライブ体験”

ーーまずは今回のARライブイベント「LOST CORNER AR LIVE in HARAKADO」に、WhateverさんとSoVeCさんが携わることになった経緯を教えてください。

渡辺:もともと、新アルバム発売記念として、ARライブを実施する企画をREISSUE RECORDSさんとSIXさんが立ち上げていて、そこに弊社もお声がけいただきました。SIXさんとは以前にもLyric Speakerのプロジェクトでご一緒していましたし、弊社もハローキティ50周年記念のARアプリや、自社のファサードに設置している巨大なQRコードを使ったARミュージアム「MoAR」などを手がけていて、ARに対する知見もたまってきていたので。そして、今回のライブはハラカドの6、7階から交差点を見下ろす形で行われる体験が前提にあり、かつARの精度にはこだわりたかったので、その両方を実現できるのはSoVeCさんしかいないと思い、お声がけしました。

上川:僕らは約4年前にVPS(Visual Positioning System)を使った次世代ARアプリ「XR CHANNEL」をリリースしました。VPSとは、カメラの画像情報を利用して位置を特定する先端技術で、当初はその位置精度が課題となっていました。満を持してソニーが開発したVPSを導入したところ(SoVeCはソニーグループの企業)、精度が圧倒的に高く、これはいけるぞ、と。その後、その精度の高さを利用してさまざまな新しい表現にチャレンジしてきたのですが、徐々に認知が広がり、多くの企業やクリエイティブ業界の方々にお声がけいただくようになりました。今回のお話をいただいた時は内容を聞いて「ぜひやりたいです」と即答し、すぐに高山にハラカドに行ってもらって。VPSに適しているか、まずはラフな3Dマップを制作して認識精度を試したら、こんな良い場所はないってくらいのロケーションでしたね。

ーー絶好のロケーションではありつつ、制作には高度な技術が求められるかと思います。交差点という象徴的な場所でのARライブ制作は、どのように進めていったのでしょうか?

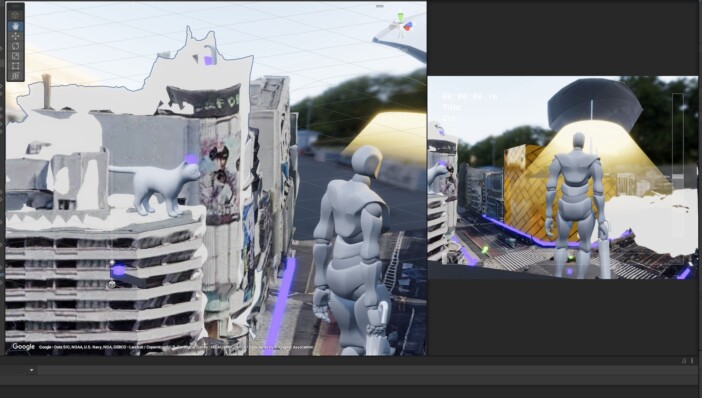

高山:まずVPS用に現地を動画で撮影し、そのデータからマップと点群データ(3Dモデルの元となるデータ)を生成します。それを簡易的にメッシュ化して、ワイヤーフレームにしてモデルを作り、SoVeCのアプリである「XR CHANNEL」のモデルにのせたものを、みなさんにお見せしました。

衣袋:早い段階で現場の実寸モデルを読み込み、遠隔でもシミュレーションできる環境を構築して、ARでどう見えるかのプリビズ(※)を、演出の田向さん・SIXさん・チームのメンバーで共有することができました。本番と同じ画角で自由にカメラを動かすことで、演出コンテでは見えない画角の問題点を見つけたり、リアルな見え方をイメージしながら制作を進められたんです。事前の演出シミュレーションにもSoVeCさんの技術力が最大限に活かされました。

(※)完成形をイメージしたシミュレーション映像

ーー演出を考えるうえでも、早い段階から技術チームと密に連携していたんですね。

上川:僕らがコンテンツを制作する際には、企画側に3Dマップデータを渡してそれをもとに作ってもらって、僕らが後から実装することも多いのですが、今回は演出を練る段階から参加しました。ユーザーの体験フローや、どんなデバイスを使って何処で体験するのか、そして、表現したいコンテンツの内容や細部のこだわり、制約のある環境の中で何を最優先にするのか、など、考えるべきことはたくさんあったので、密にコミュニケーションをとりながら進めました。

エフェクトが飛び交う豪華演出の裏で光った“SoVeCの技術力”

ーーライブ中のキャラクターは、米津玄師さんが描かれた「LOST CORNER」のジャケットをもとに作られていますが、原宿という舞台で動き回る姿を表現するには、いろんな制約もあったかと思います。デザイン面で工夫されたところや、苦労されたところを教えてください。

高谷:ARでのライブなので、ご本人が歌っている印象になるように意識しました。引きで見てもアップで見ても米津さんだと感じられるよう、輪郭や目の位置を1ピクセル単位で調整して。僕の中での米津さんは、パーツなどの印象はシャープですが、立ち振る舞いや体のニュアンスは柔らかいイメージだったので、ボディラインは柔らかく、バランスを整えました。

ーー今回ARライブをするにおいて、参考にしたコンテンツはありますか?

渡辺:今回の話が来たときから、チーム内でもGorillazがタイムズ・スクエアやピカデリーサーカスで行ったARライブはベンチマークとしてあり、それとは異なる米津さんならではのユニークネスや技術面での進化、新たなチャレンジは強く意識しました。米津さんらしいダイナミックなステージパフォーマンスから、膨大な演出オブジェクト、一体感を感じられるインタラクティブ演出まで、現時点のモバイル端末スペックで考えうる最も没入感があってリッチなARライブを目指そうと。

吉原:圧倒的な精度を持つソニーのVPSならではの表現を追求し、周辺の建物の造形を活用した表現や、米津さんのキャラクターが縦横無尽に動き回り、曲によって変化する繊細な演出を実現できたと思っています。

渡辺:ARライブに没入して夢中になってもらうことと、事後にSNSにシェアしてもらうこと、どちらも今回の施策にとっては大事なことなので、最適なバランスを模索して今回のような形になりました。

ーー冒頭からビルを飛びながら歌うなど、豪華な演出も見どころですね。単なるアクションシーンだけでなく、さまざまな効果を使った演出を、破綻しないようにまとめるのは大変だったのではないでしょうか?

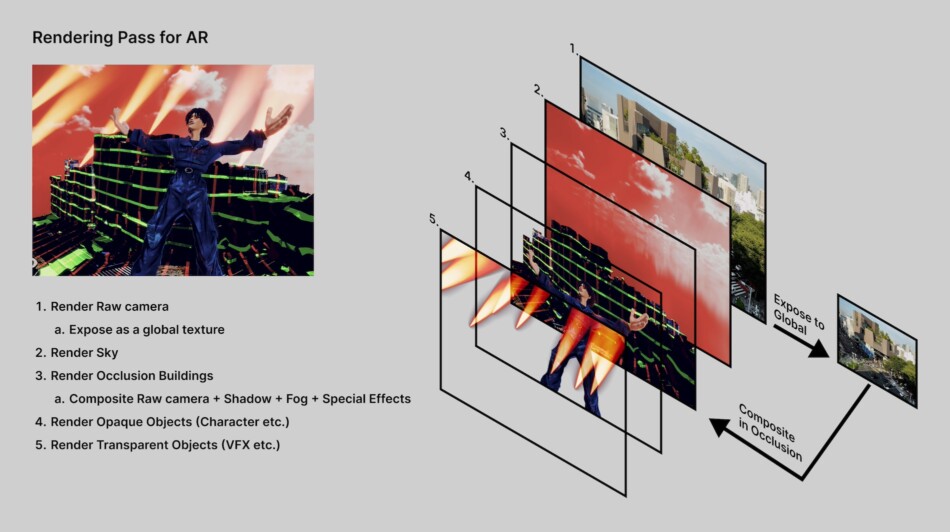

衣袋:「KICK BACK」のシーンでいうと、実は意外とシンプルな仕組みで作られています。VPSでは建物や地面の位置が把握できているから、カメラ映像の建物や地面以外が空だとわかるんですね。カメラの位置、iPadに映るカメラ映像で、空を特定して、画像合成してエフェクトを重ねています。

ーー映像にない部分を先に作ってから、建物を重ねていく形なんですね。

衣袋:そうですね。建物については点群モデルがあったので、それをもとに自分たちでモデリングしました。そのモデルを空間に配置し、カメラ映像とエフェクトを合成する形です。あと建物と空のエッジが気になったので、エフェクトで馴染むように調整しました。

渡辺:演出側とコミュニケーションするにあたっては、最初に演出コンテを考える時に、“AR映えしそうな演出ブレスト”を作って監督にお渡ししました。それを監督がコンテに取り入れたり、「こういう演出をやりたいんだけど、どう見える?」と衣袋に投げかけると、彼がデモを作ってくれたりして。それを見ながら制作を進めていきました。初期段階でイメージが固まっていたので、後はその解像度を高めていく作業に注力できたのも大きいです。

ーーそうしてメンバー間でゴールのイメージが早い段階で共有されると、クリエイティブの質も上がりますよね。SoVeC側ではVPSの技術提供に始まり、途中段階ではどのような作業をおこなったのでしょうか。

高山:制作する中で修正点をご相談いただいて、ブラッシュアップを重ねていきました。

登山:これがSoVeCさんのすごいところですよね。すでに作ったマップに、部分的に新しい情報を追加していただけたので、開発スピードがかなり上がりました。

ーーそこ、もう少し詳しく伺いたいです。

高山:これはフォトグラメトリと呼ばれる、複数の視点で撮影した画像から、対象の3D構造を復元する技術です。複数の場所でこの作業を行う場合、それらを一つのフィールドでマージする必要があり、その際すでに作成されたデータに対して「ここにこれがある」という位置を再度ローカライズします。ローカライズというのは、カメラで撮影した映像の自己位置を計算して、その映像を既存のデータに重ね合わせる作業です。ローカライズの精度が低いとデータがずれてくるので、ぴったり合わせないとダメなんですね。

ーーつなぎ目部分にずれが出ないように、ぴったり合わせる作業が必要になると。

高山:そうですね。データ同士が重なる部分を基準にして、正確に合わせる必要があります。今回は基本的にすべてオモカドを中心に撮っていて、そこから追加する部分を足していきました。たとえばハラカドの下の部分を撮りたいときも、オモカドを中心にして撮れば、オモカドを撮ったカメラと上から撮ったカメラの位置関係が揃うので、マップを正確に結合できるんです。

上川:今回は「XR CHANNEL」で洗練してきた技術を、アプリではなくデジタルツイン技術として提供していて。VPSのベースとなる3Dマップ制作とその周辺技術を惜しみなく提供しています。VPSは一般的には夜は認識精度が落ちて使えないものなのですが、ソニーのVPSは都市の明るさであれば認識するロバスト性を持っています。ただ、昼と夜は認識するマップの特徴が違うため、別々のマップを制作して時間によって切り替えるようなやり方が必要なこともあります。でも、今回は最終的には完全に昼と夜のマップをマージしちゃいました。今回のロケーションがVPSには絶好の環境で、昼夜の認識率が持続するスーパーマップが出来たからです。

ーー簡単に言いましたけど、昼と夜のマップをマージするって……すごい発想ですし、実現するものなんですね。

上川:過去の事例で確立した手法なのですが、最初はびっくりしましたけどね、こんなことができちゃうのかって。今回特にこの手法が活きたと思います。