完全なる“俺の嫁”は実現するのか? 対話型AIの目まぐるしい進化の先に見える「人格的AI」の可能性

2023年のテック系ニュースを賑わす話題のひとつとして、対話型AIの動向がある。直近でもっとも話題になった対話型AIと言えば「ChatGPT」を思い浮かべる方も多いだろう。2月には早くも“ポストChatGPT”をめぐる覇権争いが激化している。

ところで、アニメやゲーム、ライトノベルなどのサブカルチャー文化において、“俺の嫁”という言葉が存在する。これは自分にとっての理想のキャラクター、あるいはお気に入りのキャラクターに対して使われるものだ。男性側からだけでなく、女性が使うこともあり、「スパダリ」など似た言葉も存在する。

激化するAIの開発競争の果てに「心ある人間と交流している」と思わせてくれる「人格的AI」、くだけた言い方をすればAI技術によって完全なる“俺の嫁”が誕生する可能性はあるのだろうか。本稿では対話型AIの現状や仕組み、「AIの心」をめぐるエピソードに言及したうえで、Stable Diffusionなどの画像生成AIと組み合わせた延長線上に浮かび上がる未来の“俺の嫁”像について考えてみたいと思う。

大手テック企業が続々参入

はじめに、対話型AIにおける大手各社の開発状況を振り返ろう。

ChatGPTを開発したOpenAIと技術的提携を結んでいるMicrosoftは2023年2月8日、最先端対話型AI「Bing AI」を検索エンジンBingに実装、Edgeブラウザでも利用可能となることを発表した。このBing AIとChatGPTの最大の違いは、前者がインターネット検索を可能としていることだ。

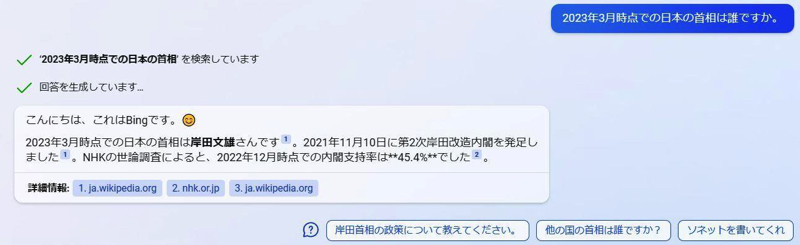

ChatGPTの学習モデルは2021年9月までのデータを利用しているため、時事問題や最新ニュースを苦手としていた。しかし、前述した違いによりBing AIはそうした話題に対しても適切に答えられるようになったのだ。実際に「2023年3月時点での日本の首相は誰ですか」と質問すると、「岸田文雄」と答えるとともに、追加情報を出典を明記したうえで提示してくれる。

〈出典:「AI を搭載した新たな Microsoft Bing と Edge が検索を再発明 ― ウェブの副操縦士」〉

Bing AI発表の前日、2023年2月7日にはGoogleが対話型AI「Bard」を発表した。このAIは2年前から同社が開発している対話型AIの「LaMDA」をベースに開発されたものだ。、インターネット検索にも対応しており、Googleによれば「NASAのジェイムズ・ウェッブ宇宙望遠鏡による新発見を9歳の子供に説明したり、現代サッカーにおける最高のストライカーについて学んだりできる」と説明されている。「Bard」はテストユーザーによる試験運用がすでに始まっており、いずれ一般向けにも公開されると見られている。

〈出典:「AI の次の重要な一歩」〉

Metaも2023年2月24日、言語AI「LLaMA(Large Language Model Meta AI)」を発表している。前述した2つのAIと違い、このAIは一般ユーザーには公開されず、研究者向けのAIとして公開されたものだ。

〈出典:「Introducing LLaMA: A foundational, 65-billion-parameter large language model」〉

日本国内に目を向けると、画像生成AI「Stable Diffusion」を開発するstability AIの日本公式ツイッターアカウントは2月20日、日本語に特化した対話型AI「Stable Chat(日本語版)」の開発がスタートしたことを発表した。

日本語に特化した、今までないチャットボット「Stable Chat(日本語版)」を開発します!

世界トップクラスの技術、大規模GPUクラスター、オープンコミュニティの力など… 私たちの強みを生かした透明性の高い最高の大規模言語モデル(LLM)を構築します。1/2

— Stability AI 日本公式 (@StabilityAI_JP) February 20, 2023

以上のように、対話型AIにおける開発競争は激化の一途をたどっており、巨大テック企業による群雄割拠の様相を呈しつつあるのだ。

「AIの脳力」をめぐるモデルサイズ競争

さて、このようにして対話型AIが乱立するようになると、それらの性能をわかりやすく比較する指標が欲しくなるだろう。こうした指標のひとつとして挙げられるのが「モデルサイズ」だ。「モデルサイズ」とは、対話型AIの性能に影響を与える「パラメータ数」を意味する。パラメータをわかりやすい比喩で説明すると、AIに含まれる“擬似的な脳細胞”である。つまり、パラメータ数が多ければ、AIはより複雑かつ柔軟に情報を処理して、問いに対して適切に回答できるようになるということだ。

ChatGPTのベースになったモデル、2020年5月に発表されたGPT-3のパラメータ数は、1,750億である。言語を処理するAIの研究分野である「自然言語処理」の世界において、GPT-3は画期的な進歩を遂げたものとされており、人間が書いたかのような自然な文章を生成可能にしたことで大きな話題となった。同AIは後にAPI(別のアプリケーションでも同AIを利用可能にする、出入り口に相当するもの)として開発者に提供されるようになり、現在でも各種AIサービスなどに活用されている。

〈出典:「Language Models are Few-Shot Learners」〉

このGPT-3の登場以降、モデルサイズをめぐる開発競争が勃発したのだ。この開発競争にはGoogleやMicrosoft、さらには大手GPUメーカーのNVIDIAなど多くの巨大テック企業が参戦した。近年の言語AIでモデルサイズが最大級のものは、Googleが2022年4月に発表した5,400億のパラメータをもつPaLMである。GPT-3発表当時の2020年5月から比較すると、言語AIのパラメータ数は2年で3倍以上になったわけで、この開発スピードは「2年ごとに集積回路上のトランジスタ数が2倍になる」という将来予測で有名なムーアの法則を上回っている。

〈出典:「Pathways Language Model (PaLM): Scaling to 540 Billion Parameters for Breakthrough Performance」〉

しかし、言語AIをめぐるモデルサイズ競争は、2022年後半には早くも新展開を迎えた。開発競争の焦点がパラメータ数だけではなく、「効率性」も重視されるようになったのだ。この文脈における効率性とは、「パラメータ数を増やすことなく、同等の性能を実現すること」を意味する。こうした新局面への移行をうけて、前出のMetaのLLaMAは、効率性を重視して開発したことを強調している。

〈出典:「LLaMA: Open and Efficient Foundation Language Models」〉

モデルサイズ競争から発展して、今度は効率性を重視するようになったことで、言語AI開発競争はさらに大きな伸びしろを得たと言える。したがって、ChatGPTやBing AIを大きく上回る対話型AIが今後登場する可能性は十分にあると筆者は見ている。

そして2023年3月15日、OpenAIはGPT-4を発表した。同AIは言語能力でChatGPTを凌駕し、食材が写った画像を入力として渡すとその食材で調理できるメニューを提案するような画像認識能力も実装された。同モデルは言語能力と画像認識能力を兼ね備えた新次元のAIであり、今後のAI開発競争は同AIが基準となるだろう。

〈出典:GPT-4 is OpenAI’s most advanced system, producing safer and more useful responses〉