『AlphaGo』から『MindAgent』まで ゲームプレイAI進化の歴史をたどる

2016年3月、Google傘下のAIスタートアップ企業・DeepMindが開発した囲碁プレイAI『AlphaGo』が人間のトッププロ囲碁棋士に勝利したことで、AIが一気に世界の注目を集めるようになった。

『AlphaGo』以降も、最新AI技術の有効性を実証するために数々のゲームプレイAIが開発されており、現在も進化を続けている。本稿ではこうした近年のゲームプレイAIの発展を振り返ることで、「AI技術」と「ゲーム」の深い関係を明らかにしたい。

囲碁用に誕生したAIがYouTubeの通信量削減に活躍 『AlphaGo』の誕生

ゲームがAI研究のテーマになるのは、それが明確なルールによって定義された知的活動だからである。ルールが明確なのでゲームプレイの内容を情報処理の形式に変換しやすいうえに、開発したAIをゲームの勝敗によってわかりやすく評価できる。

歴史ある対戦型ボードゲームであるチェスや将棋をプレイするAIの研究はAI史の早い段階から取り組まれており、こうした研究から人間のトッププレイヤーを凌駕するAIが誕生している。囲碁プレイAIも同様に取り組まれていたが、考えられる打ち手の膨大さゆえに「人間を凌駕するAIの開発はむずかしい」とAI研究者たちは考えていた。

しかし、以上のような想定を打ち破ったのが『AlphaGo』である。同AIは第3次AIブームによって注目されるようになった「ディープラーニング(深層学習)」を活用することで、2016年3月、トッププロ囲碁棋士のイ・セドルに勝利した。

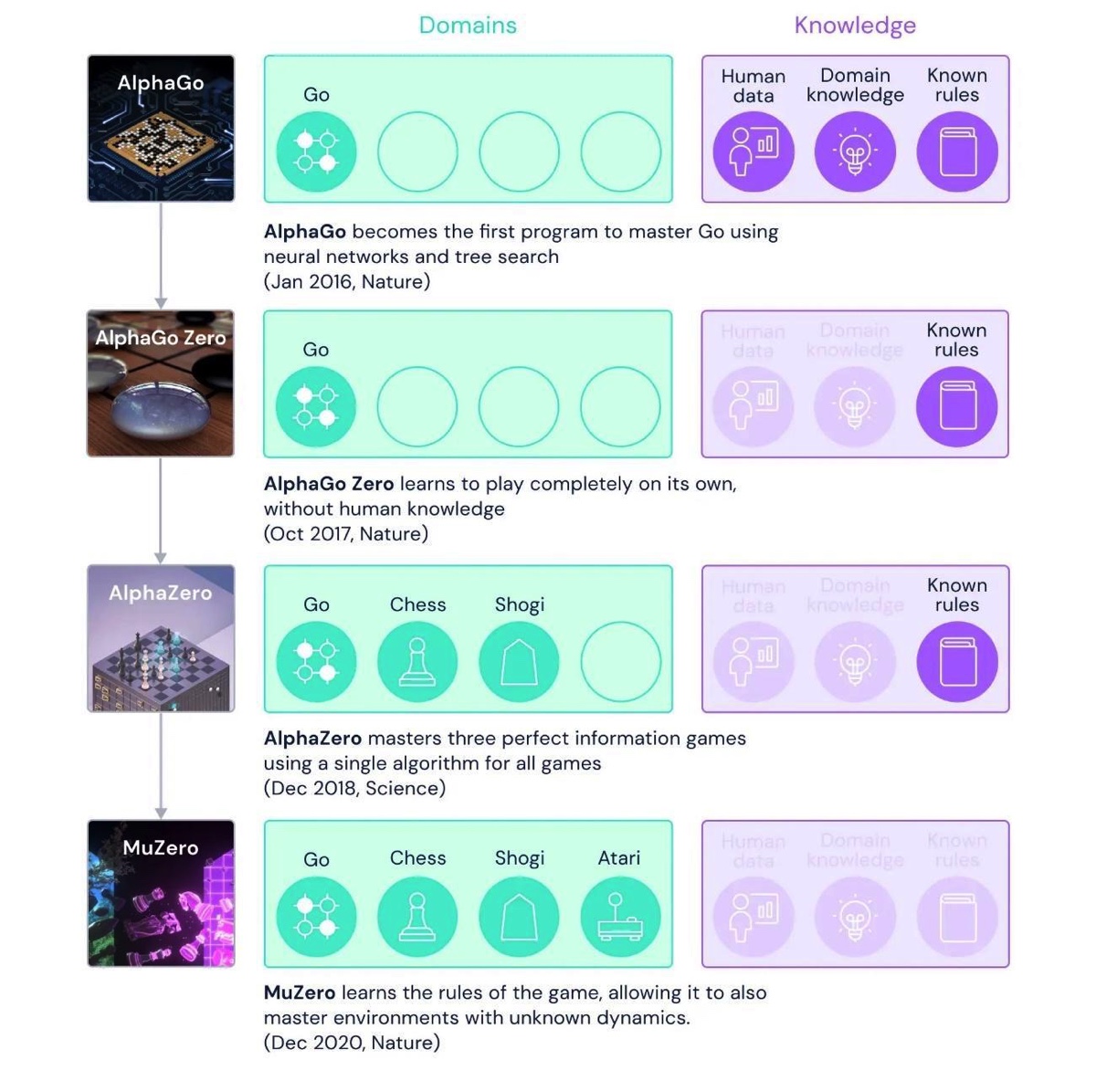

『AlphaGo』を開発したDeepMindは、このAIをさらに進化させていった。『AlphaGo』は大量の棋譜を学習することで棋力を上げていたのだが、2017年10月に発表された『AlphaGo Zero』は学習データを必要とせずに『AlphaGo』を凌駕した。『AlphaGo Zero』は自分自身と対戦するセルフプレイによって、棋力を上げたのだ。さらに2018年12月に発表された『AlphaZero』は、セルフプレイによってチェス・将棋・囲碁の各世界チャンピオンプログラムに勝利するという高い汎用性を実現した。

2020年12月に発表された『MuZero』に至っては、チェス・将棋・囲碁に加えて、ブロック崩しをはじめとする多数のレトロゲームでも当時のゲームプレイAIにおけるトップスコアを記録した。驚くべき点としては、このAIはゲーム環境に適応するように学習するので、ゲームのルールが未知な状態(AIにルールをあらかじめ学習させていない状態)からでもプレイを上達させられたことだ。

〈出典:MuZero: Mastering Go, chess, shogi and Atari without rules〉

なお『MuZero』は現在、YouTubeの通信量削減に応用されている。通信データ最適化を1種のゲームとして見立てたうえで、この「最適化ゲーム」を『MuZero』によって解決しているのだ。

「友情破壊ゲーム」で人間を凌駕 AIが導き出した“最適の戦略”とは

『AlphaGo』とその後継モデルがプレイしたゲームは、基本的にプレイに必要な情報のすべてがプレイヤーに与えられることから「完全情報ゲーム」に分類される。対してポーカーなどのようにプレイに関わる情報の一部(とくに対戦者の状態)が与えられないゲームは、「不完全情報ゲーム」と呼ばれる。

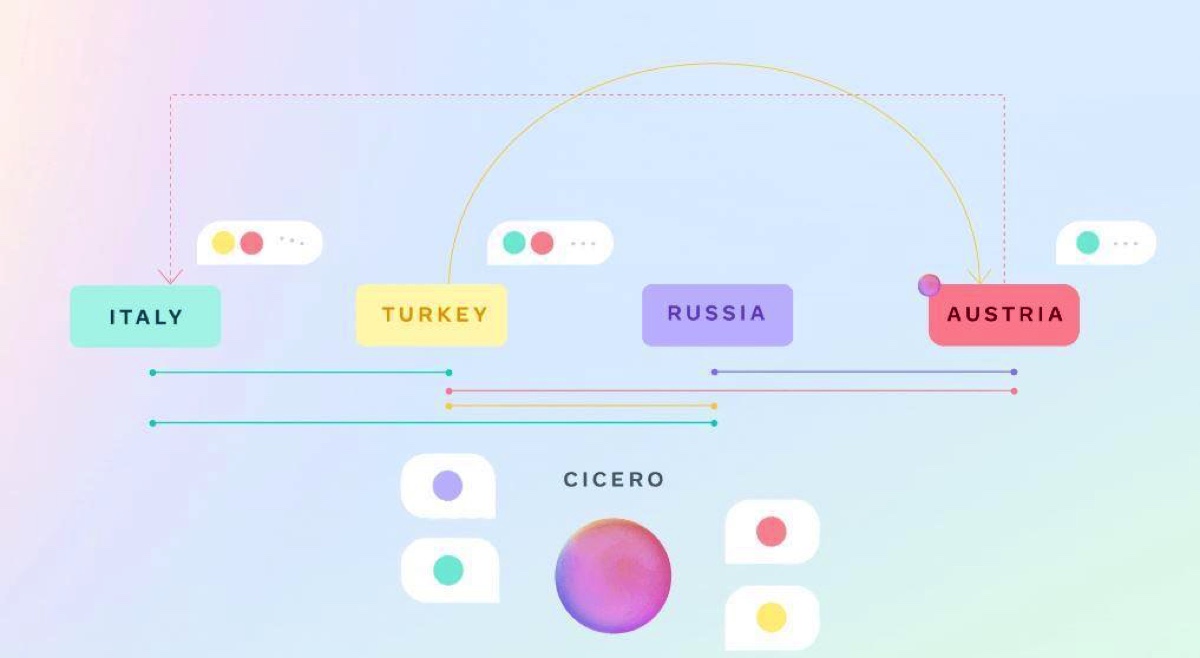

不完全情報ゲームに分類されるボードゲームのひとつとして、外交シミュレーションゲーム『ディプロマシー』が知られている。このゲームは第一次世界大戦前のヨーロッパを舞台として、7名のプレイヤーがヨーロッパ制覇を目指してそれぞれ1ヵ国を担当するというものだ。プレイ中はプレイヤー間で言葉による「交渉」が認められているのだが、こうした交渉においては相手の真意がわからず、結成した同盟が裏切られることもある。裏切りさえも勝利のための手段となり得ることから、同ゲームは「友情破壊ゲーム」の異名がある。

Metaは2022年11月、『ディプロマシー』をプレイするAI『CICERO(キケロ)』(※1)を発表した。このAIは同ゲームをオンラインでプレイできるウェブサイトwebDiplomacy.netから収集した4万以上のプレイログを学習したことで、人間プレイヤーと交渉できる文章生成能力を獲得した。

【※1……CICERO(キケロ)という命名は、古代ローマの政治家にして文筆家・哲学者でもあったマルクス・トゥッリウス・キケロ(Marcus Tullius Cicero)に由来すると考えられる】

Metaの研究チームは、『CICERO』の実力を調べるためにオンラインで『ディプロマシー』をプレイできるwebDiplomacy.netで40回にわたり人間のプレイヤーと対戦させた。その結果、40回の平均勝率は25.8%であり、参加した人間プレイヤーの平均である12.4%の2倍以上という好成績を収めたのだった。

〈出典:CICERO: An AI agent that negotiates, persuades, and cooperates with people〉

〈参考論文:Human-level play in the game of Diplomacy by combining language models with strategic reasoning〉

『MuZero』のDeepMindも2022年12月に『ディプロマシー』のプレイAIに関する研究を発表した。もっとも、この研究はヒューマンライクに同ゲームをプレイするAIの開発ではなく、AIにゲームをシミュレーションさせることで“最適な戦略”を探求することを目的としていた。

この研究によって、過去の対戦履歴にもとづいて「裏切ることによって得られる利益」がそれによって被る被害を上回ると判断できた場合にのみ裏切る、という戦略が“最強”であることがわかった。もっとも、この戦略でプレイした場合でも裏切る確率は1%未満になるということも判明した。つまり、この結果からすると『ディプロマシー』のプレイにおいては基本的に「誠実であること」が勝利につながると言えよう。

〈出典:AI for the board game Diplomacy〉