OpenAI騒動帰結の“先”を考える アルトマン復帰によって「超知能の実現」が加速するか

騒動の火種となった可能性のある1本のレポート

OpenAI騒動の原因に関して、同社は公式ブログ記事でアルトマンCEOが「理事会とのコミュニケーションにおいて一貫して率直さを欠いていた」とやや主観的に述べるにとどまっている。それゆえ、理事会でどのような対立が生じていたのかに関して、現時点で具体的にはわかっていない。

こうしたなかイギリスメディアThe Guardianは2023年11月23日、OpenAI騒動の火種となった可能性のある1本のレポートについて報じた(※3)。そのレポートはアルトマンCEO解任当時、OpenAI理事会メンバーを務めていたヘレン・トナー(Helen Toner)氏が執筆したものである。

政治学において世界最高峰と評価されるアメリカ・ジョージタウン大学の「CSET(Center for Security and Emerging Technology:安全保障・新技術センター)」にも所属しているトナー氏は2023年10月、同センターの研究員と共著で「AIの安全性」に関するレポート(※4)を発表した。このレポートは政策立案者がAIにまつわるリスクを評価する方法を論じているのだが、「民間セクターからのシグナリング」と題された節では民間企業から発せられるAIリスクの兆候を考察している。

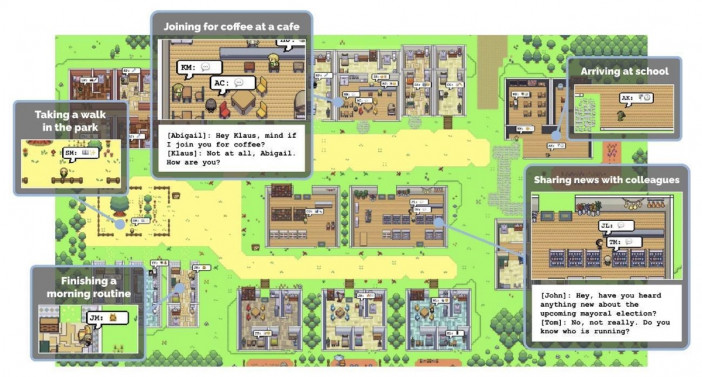

当該の節では、2023年のOpenAIとChatGPTの競合AI『Claude』を開発するAnthropicが対比されている。2023年3月、OpenAIは『GPT-4』を発表した際に、そのリスクについてまとめたシステムカードとともにリリースした。しかし、こうした企業活動は真にAIリスクを軽減するものではない、とトナー氏執筆のレポートは批判している。対してAnthropicは、『GPT-4』のリリースを受けて、安全性に万全を期すためにClaudeのリリースを意図的に延期した。同レポートは、このAnthropicの決断を「AIリスクに真摯に向き合ったもの」として称賛している。ちなみに、Anthropicは10月17日より『Claude』を日本を含む95ヶ国で展開しており、11月22日には『Claude 2.1』を公開している。

OpenAIを名指しで批判したレポートの内容に関して、アルトマンCEOとトナー氏とのあいだで確執が生じたことを前出のThe Guardianの記事は伝えている。そして同レポート公開後、OpenAI騒動が起こったもののアルトマンCEOは復帰した。一方で、2023年11月30日、トナー氏はOpenAI理事会メンバーを辞任したとXにポストした。

Today, I officially resigned from the OpenAI board.

Thank you to the many friends, colleagues, and supporters who have said publicly & privately that they know our decisions have always been driven by our commitment to OpenAI’s mission.

1/5— Helen Toner (@hlntnr) November 30, 2023

諸刃の剣「Q*」をめぐるOpenAI社内の摩擦

OpenAI社内のAIリスクをめぐる動きについては、ロイター通信も2023年11月23日に報じている(※5)。その報道によると、OpenAI騒動が起こる少し前に人類を危機に晒しかねない強力なAIを実現するアルゴリズムに関する書簡が同社理事会に提出された、と匿名の同社関係者は語っている。

そのアルゴリズムは「Q*」(読み:キュースター)と命名されており、AIの数学的推論能力を大きく進化されるものとされている。ChatGPTを含む現在の対話型AIは数学的推論を苦手としているが、『Q*』が実用化されれば、「汎用人工知能(すべての分野において人間と同等の知的活動ができるAI)」の実現に向けて大きく前進する。しかしながら、汎用人工知能実現への接近は人類が制御できないAIが誕生するリスクもはらんでおり、前出の書簡は『Q*』の危険性も指摘していたようだ。

ところで、ChatGPTを含む現在の対話型AIはなぜ数学的推論を苦手としているのだろうか。この疑問に関しては、国立情報学研究所が主催している教育機関DXシンポの第67回(2023年7月7日オンライン開催)で発表された湊 真一京都大学教授の作成資料(※6)がくわしく論じている。結論からいえば、ChatGPTは計算結果を書いたり文章を読んだりする「読み書き」だけを学習しているのであって、実際の計算を学習していないのだ。つまり、同AIは算数の教科書を読んではいるが、計算練習を全くしていないというわけである。

以上をふまえると、数学的推論能力を有する『Q*』が非常に革新的なアルゴリズムであるとわかるだろう。そして、このアルゴリズムが理事会に報告された直後にアルトマンCEOが解任されたとなると、理事会で同アルゴリズムに関する何らかの対立があったのではないか、とも考えられる。

汎用人工知能の先を見すえるアルトマンCEO

本稿ではOpenAI騒動の顛末と、その直前にあったAIのリスクをめぐるふたつの出来事を振り返った。そして、これらを総合すると、以下のような推理が可能ではなかろうか。

OpenAI騒動の直前、汎用人工知能実現に関する大きな前進があったものも、その前進に伴うリスクをめぐって同社理事会で互いに引くに引けない対立が生じた結果、アルトマンCEOが解任されてしまった。そして、状況が二転三転した後に同CEOが復帰した一方で、AI開発に関して慎重派と目されるトナー氏が理事会メンバーを辞任したことを鑑みれば、騒動後の同社はAI開発推進派であらためて団結した。

これはあくまでも筆者の推理に過ぎない。しかし、以上の推理を補強するかも知れない言葉が、前出のOpenAI騒動の終結を宣言した同社ブログ記事のなかにある。それはアルトマンCEOの“決意表明”ともとれる一文で、「私は、世界最高のチームであり、世界最高のミッションに携わっている(OpenAI社員である)皆さんとともに、有益なAGI(Artificial General Intelligence:汎用人工知能)を作り上げる仕事を終えることをとても楽しみにしています」と表現されている。

この一文で注目すべきは、汎用人工知能の実現を「終えることを楽しみにしている」と表現している点だ。つまり、汎用人工知能実現は見果てぬ夢ではなく、終わらせることが可能なタスクと見なされているのだ。

アルトマンCEOが抱いている“夢”は、汎用人工知能実現で終わらず、その先にある「超知能(Superintelligence)」を見すえている。これは、すべての分野において人間を凌駕する人工知能を指す。

2023年になってから、OpenAI公式ブログで折りにふれて超知能が言及されるようになった。最初に言及したアルトマンCEO執筆の記事『AGI以降の計画』(GPT-4リリース前の2023年2月24日公開)(※7)では「AGIが実現した場合、この知性体は自身の進化を加速させる能力がある」と述べたうえで、こうした進化の末に誕生する「超知能」が存在する世界への移行は「人類史上もっとも重要で希望に満ちた、そして恐ろしいプロジェクト」になると語っている。

また2023年7月5日には、「超知能の管理方法」を論じたブログ記事(※8)が公開された。この記事では、まず人間が管理可能な高度なAIを開発した後に、この高度AIを介して超知能を人間に敵対しないように訓練する「AIによる超知能の管理」が提案されている。そして、こうした超知能の研究にOpenAIが有する計算能力の20%をあてることも明言されている。

今回のOpenAI騒動は、結果的に同社を汎用人工知能実現のためにあらためて団結させたと考えられる。この帰結は「汎用人工知能の実現」という目標だけではなく、その先にある「超知能の実現」が早まったことを意味するのではないだろうか。

(※1)OpenAIブログ「Sam Altman returns as CEO, OpenAI has a new initial board」

https://openai.com/blog/sam-altman-returns-as-ceo-openai-has-a-new-initial-board

(※2)Bloomberg「オープンAI社員、取締役全員の辞任要求-マイクロソフト移籍示唆」

https://www.bloomberg.co.jp/news/articles/2023-11-20/S4FG2SDWX2PS01

(※3)The Guardian「Who is Helen Toner the Australian woman ousted from the board of OpenAI?」

https://www.theguardian.com/technology/2023/nov/23/who-is-helen-toner-australian-woman-openai-chatgpt-board

(※4)CSET「Decoding Intentions | Artificial Intelligence and Costly Signals」

https://cset.georgetown.edu/publication/decoding-intentions/

(※5)Reuters「OpenAI researchers warned board of AI breakthrough ahead of CEO ouster, sources say」

https://www.reuters.com/technology/sam-altmans-ouster-openai-was-precipitated-by-letter-board-about-ai-breakthrough-2023-11-22/

(※6)湊 真一「ChatGPTはなぜ計算が苦手なのか」

https://www.nii.ac.jp/event/upload/20230707-03_Minato.pdf

(※7)OpenAIブログ「Planning for AGI and beyond」

https://openai.com/blog/planning-for-agi-and-beyond

(※8)OpenAIブログ「Introducing Superalignment」

https://openai.com/blog/introducing-superalignment

“OpenAI事変”は3日天下で収束か? サム・アルトマンCEO解任劇の経緯と背景

OpenAIのCEO、サム・アルトマンが突然解任され、共同創業者であるグレッグ・ブロックマンも退任し、まさに”OpenAI事変”…