Appleの児童虐待対策システムに懸念の声 監視システムへの転用を阻止できるのか?

Appleは5日、子どもを犯罪から守るシステムをアメリカ限定でApple製品に導入することを発表した。この機能に関して、専門家はユーザのプライバシーを脅かす可能性があると懸念を表明している。以下ではAppleの児童虐待対策システムの概要、同システムに対する主な批判と同社の回答、そして専門家の反応をまとめる。

子どもを犯罪から守るために

「子どものための拡張された保護」と題されたApple発表の資料には、児童虐待対策システムを構成する3つの機能が解説されている。これらの機能はiOS 15、iPadOS 15、watchOS 8、およびmacOSMontereyに今年後半のアップデートから導入される。同機能の解説を要約すると、以下のようになる。

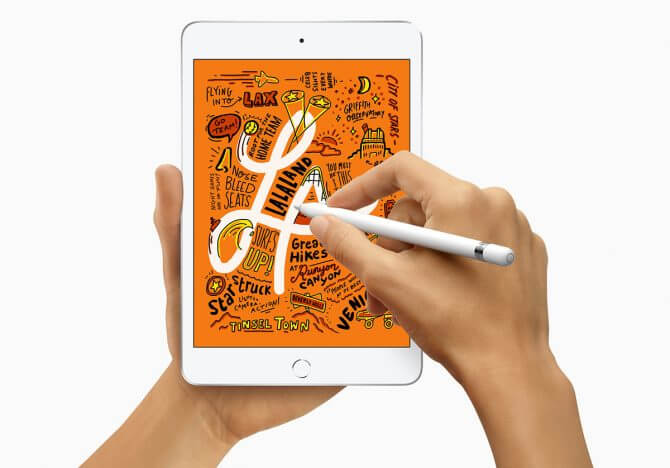

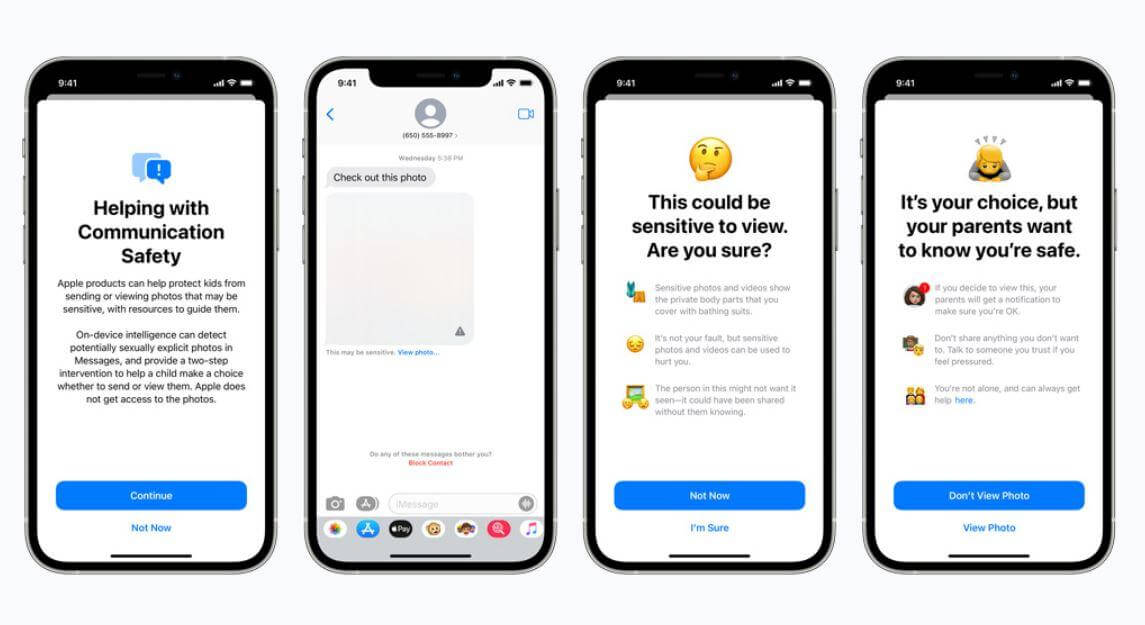

・Appleのメッセージアプリで性的に露骨な画像が送受信されると、画像がぼやけて警告メッセージが表示される。万が一、子どもが性的に露骨な画像を送ろうとした場合、画像が送信される前に子どもに警告が表示され、画像を送信してしまった時には、保護者に画像送信に関するメッセージが送信される(トップ画像参照)。性的に露骨な画像の検出はデバイス上で行われ、Appleが画像にアクセスすることはない。

・iCloud Photosに保存されたCSAM(Child Sexual Abuse Material:児童性的虐待資料、いわゆる児童ポルノ)を検出して、CSAM保有のユーザを関係法当局に報告する。CSAMの検出には、関係機関から提供されたCSAMデータベースとiCloud Photosの画像をデバイス上で比較照合する。この比較照合処理は、画像をiCloud Photosを保存する場合にのみ実行される。誤ってユーザを当局に報告する確率は、1兆分の1未満。

・SiriでCSAMを報告する方法を尋ねると、適切な回答を表示する。また、SiriあるいはApple製品の検索機能を使ってCSAMに関連した検索を行うと、検索したトピックへの関心が有害で問題があることをユーザに説明し、この問題の支援を得るためのリソースを提供する(下の画像参照)。

iCloud Photosを使用しなければ回避可能

Appleが発表した児童虐待対策システムについて、US版Tech Crunchは同社のセキュリティ責任者であるErik Neuenschwander氏にインタビューした記事を公開した。

インタビュー記事にはさまざまな質疑応答が掲載されているが、注目すべきはCSAM検出機能には政府による圧力によって監視システムへの転用を強要される可能性があるのではないか、という疑問に対する回答だろう。Neuenschwander氏の回答を要約すると、以下のようになる。

・CSAM検出機能には保護機能が組み込まれており、特定の画像を保有する個人を特定する目的に転用しようとしても役に立たない。また、特定のユーザを対象としたOSアップデートも行わない。

・同機能は、問題があると疑わる画像がしきい値を超えた場合にのみ有効となる。つまり、疑わしさの度合いを測定している。それゆえ、単に特定の画像を検出する目的に転用できない。

・同機能における検出プロセスには、人間による確認作業が含まれている。

・iCloud Photosを使わなければ、同機能の適用を回避できる。つまり、ユーザには「CSAM検出機能を使わない」という選択肢がある。

以上の回答と類似した内容は、CSAM検出機能に関するFAQにも記載されている。FAQにおいても、同機能を監視システムへ転用するような圧力に対しては断固拒否する、と明記されている。