『王様戦隊キングオージャー』にゲームエンジンが使われていた!? UEとバーチャルプロダクションを活用した特撮表現の最前線とは

8月21日から23日まで、パシフィコ横浜ノースにて『CEDEC2024』が開催された。CEDECはコンピュータエンターテインメント開発者を対象に、ゲームに関する技術や知識を共有する国内最大級のカンファレンスである。

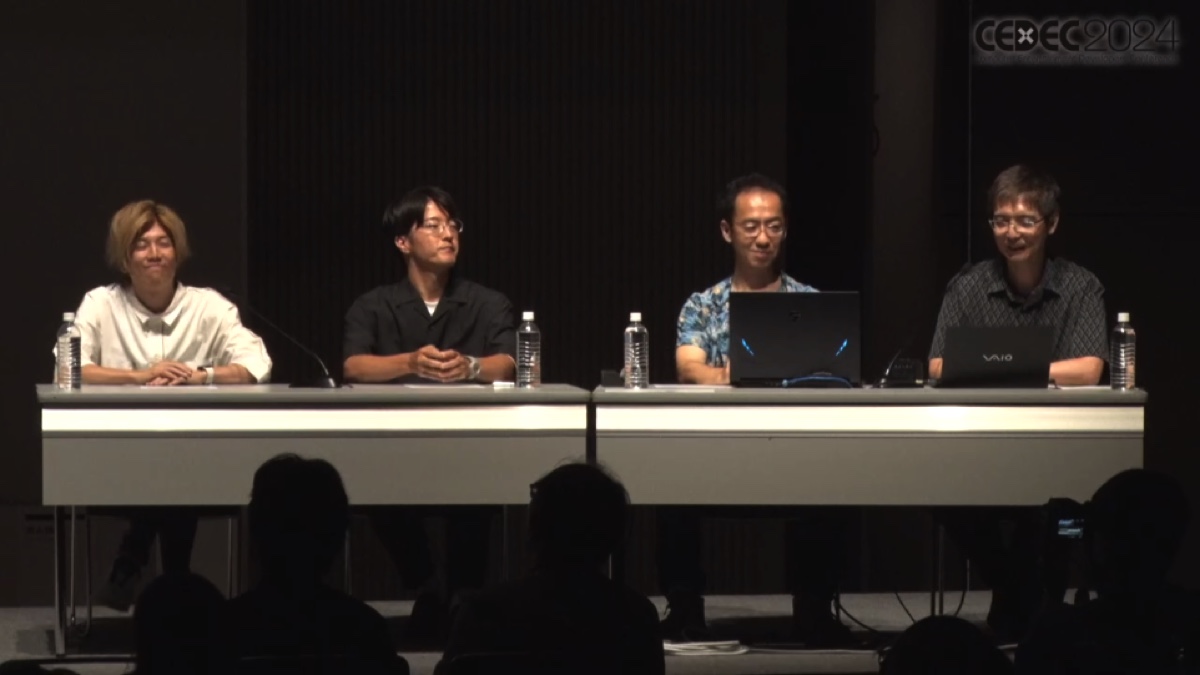

本稿では初日のレギュラーセッション「『王様戦隊キングオージャー』特撮×バーチャルプロダクション~ゲームエンジンを活用した映像表現の最前線~」をもとに、制作の流れや舞台裏をお送りする。登壇者は上堀内佳寿也氏(監督)、遠藤和真氏(ソニーPCL)、増田徹氏(ソニーPCL)、麓一博氏(セガ)で、セッションの進行は麓氏が務めた。

手探りで始まった、特撮でバーチャルプロダクションを使う試み

『王様戦隊キングオージャー』は、東映の制作チームにバーチャルプロダクションのノウハウがなく、ゲームエンジンの「Unreal Engine(アンリアルエンジン)を使うところから始まっている。

まず自分たちで背景データを制作し、ソニーPCLにLEDウォールやグリーンバックでのクロマキー撮影を含めて相談を持ちかけた。しかし、当初は持っていったUEの背景データが再生できないほど重く、撮影まで1週間を切った段階でようやくLEDウォールを含めて稼働できる状態になったという。

ソニーPCLでは、東映のグリーンバックの仕組みで使えて、LEDウォールでも正しく表示するために、最適化や負荷の軽減を試みた。もともとグリーンバックのシステム用だったため、FPS(フレームレート)が10未満まで落ち込んでいたところ、徐々に最適化のフローを踏まえてスムーズに行くようになった(※)。

(※編注:映画などの映像作品では22〜24FPSを用いるのが主流で、ホームビデオなどでは60FPSが標準設定になっていることが多い。そのため、10FPSは「映像がカクカクしている」と違和感を覚えてしまう)

従来のドラマや特撮の撮影現場では、芝居によってその場で臨機応変に対応しなければならず、CMやMVのようにキッチリとアングルを決められないことも多い。そのため、背景のクオリティーを上げる手法を採ってしまっていたのが負荷の原因だった。それでも、いったん広い背景を作り直し、それを使うことで乗り越えることができたそうだ。

今回の制作では、年間を通して8割ほどの撮影をバーチャルプロダクションで済ませた。ロケーションももちろん併用したが、なるべく車両を出さずにスタジオ内で完結させるなど、コストも含めてどういった現象が起きるのかを探る作品でもあったという。

バーチャルプロダクションの導入

前段のような予想外のハプニングはあったが、バーチャルプロダクションを用いることで、作品の深みは大幅に増している。

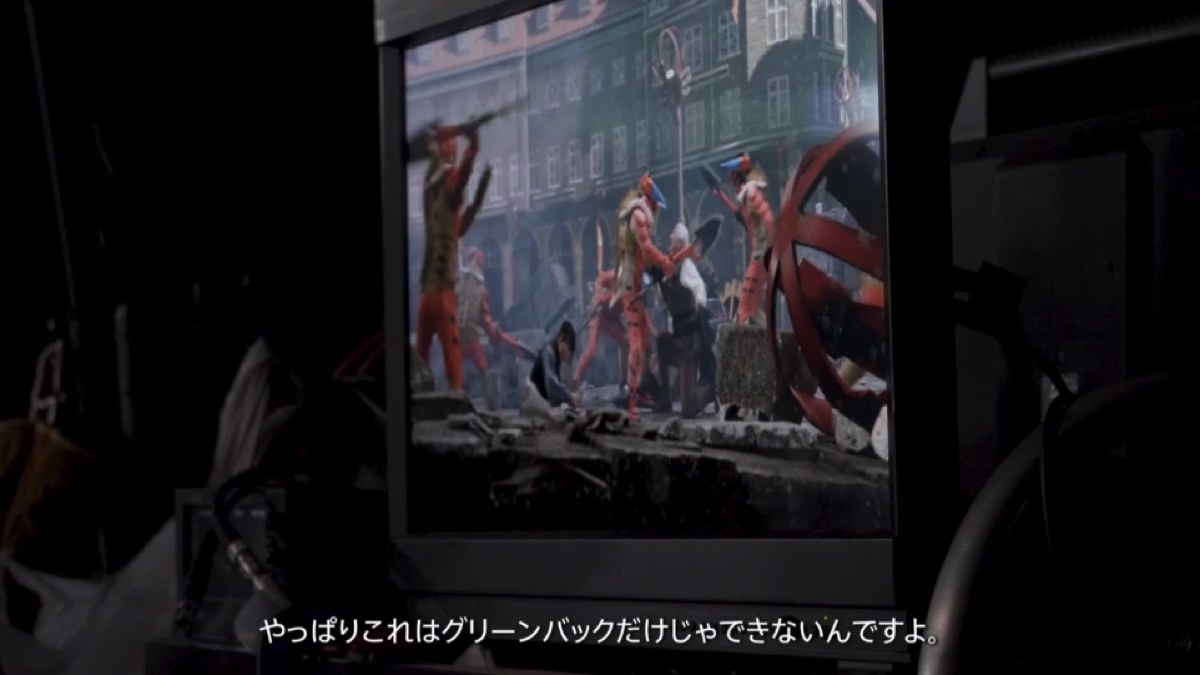

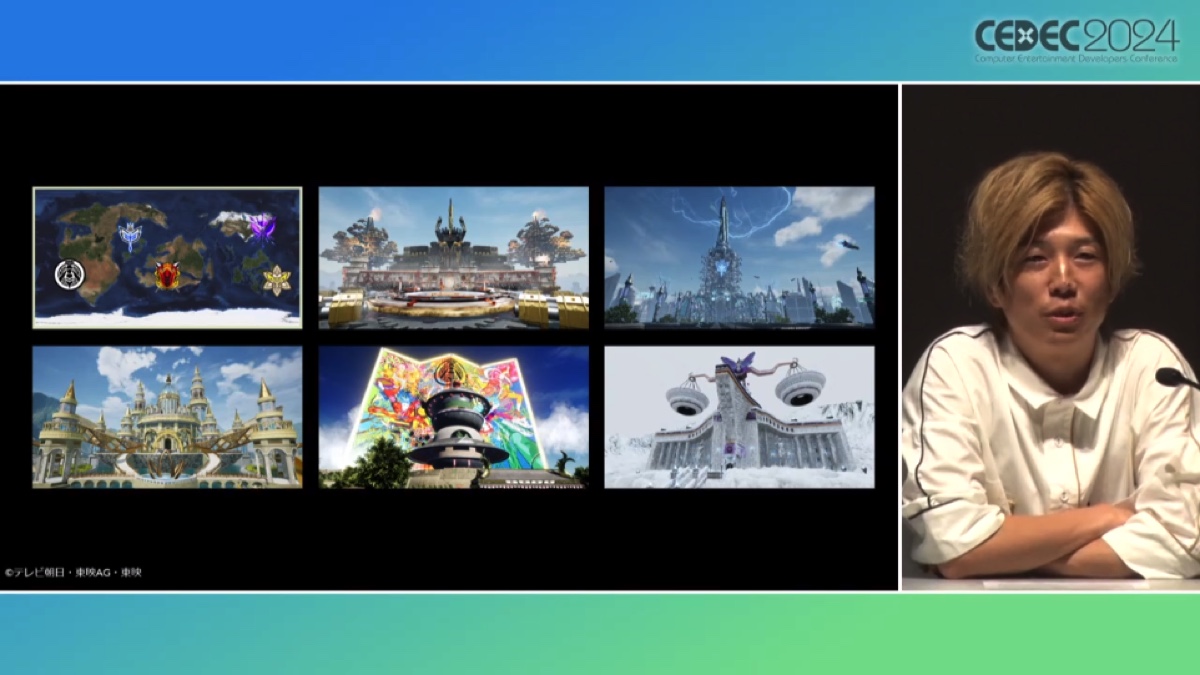

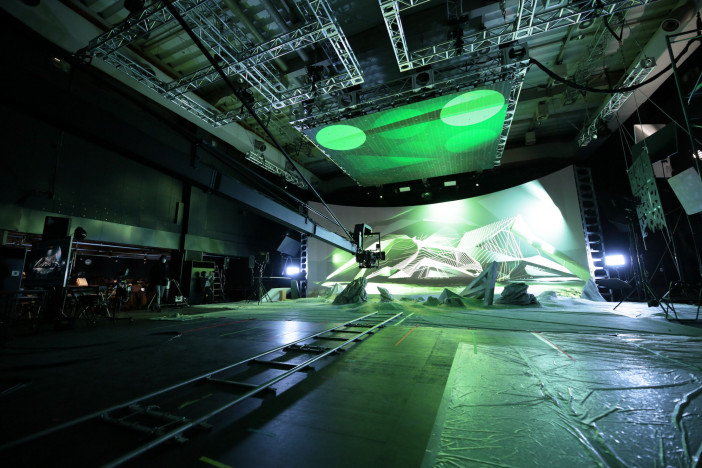

『王様戦隊キングオージャー』に登場するレッドの国(シュゴッダム国)は、特定の国がモチーフになっているわけではないが、チェコやドイツなどを想起させる中世のヨーロッパの雰囲気をイメージして撮影がおこなわれた。一方で、ブルーの国(ンコソパ国)は最先端のテクノロジーが普及する国になっており、このような正反対の表現をしようとすると、関東どころか日本ではロケーションが難しくなってくる。

しかし、バーチャルプロダクションを用いれば、これらのロケーションに困ることはなく、より作品にマッチした雰囲気の映像を制作できるというわけだ。また特撮や戦隊としても、実写よりもアニメーションやゲームに近い世界観と共存させることで、より視聴者に受け入れてもらえるのではないか。そう考えて、東映内部でプロデューサーと相談、バーチャルプロダクションを導入し、メインに据えた撮影を進めることになった。

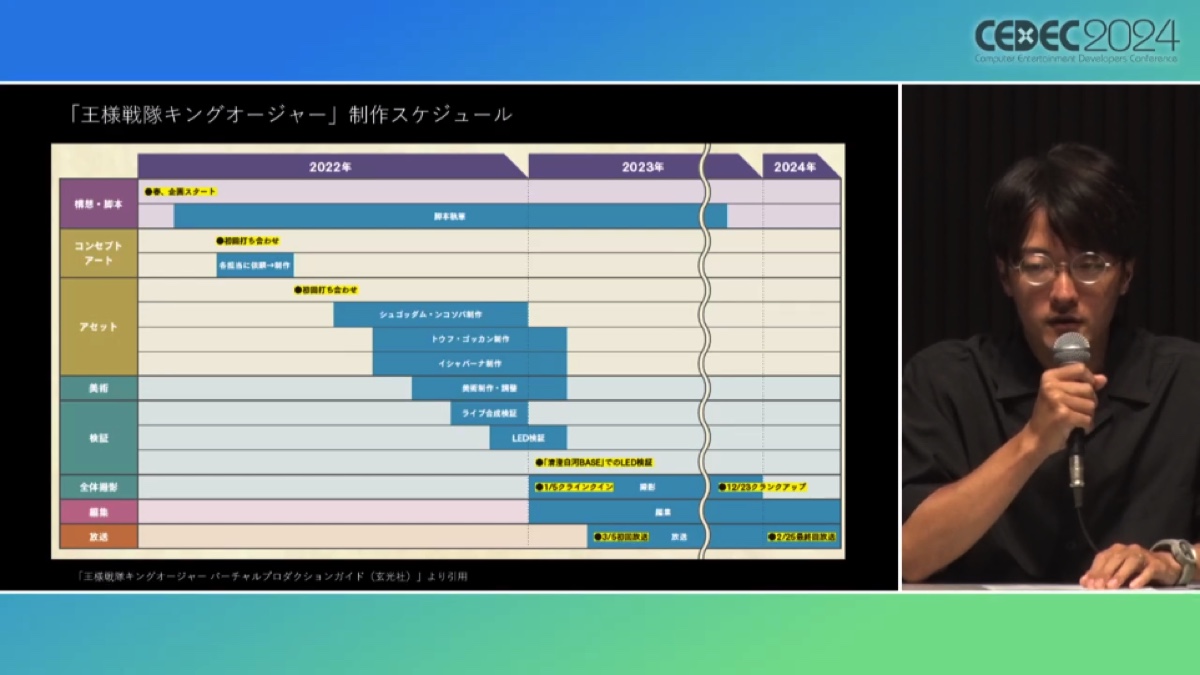

制作スケジュール

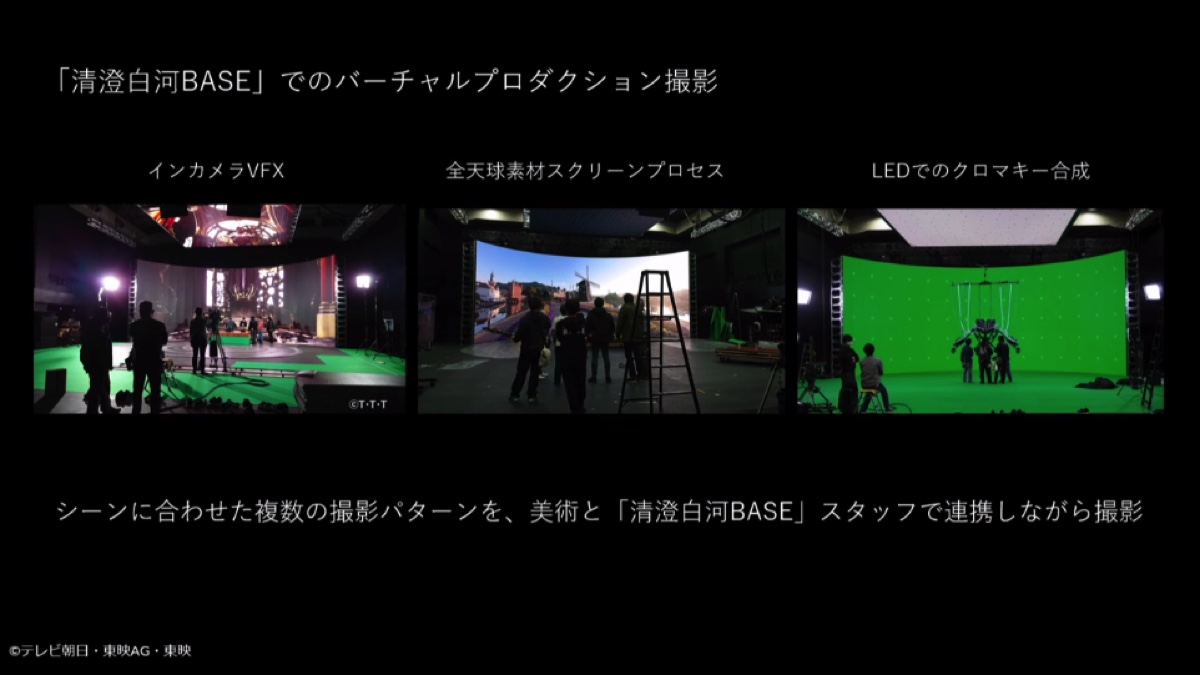

ソニーPCLでは撮影、プロダクションの領域でLEDウォールやバーチャルプロダクションのスタジオを使いながらロケーションもおこない、東映のグリーンバックも使うという体制。そして後半で説明するボリュメトリック撮影も用いていた。

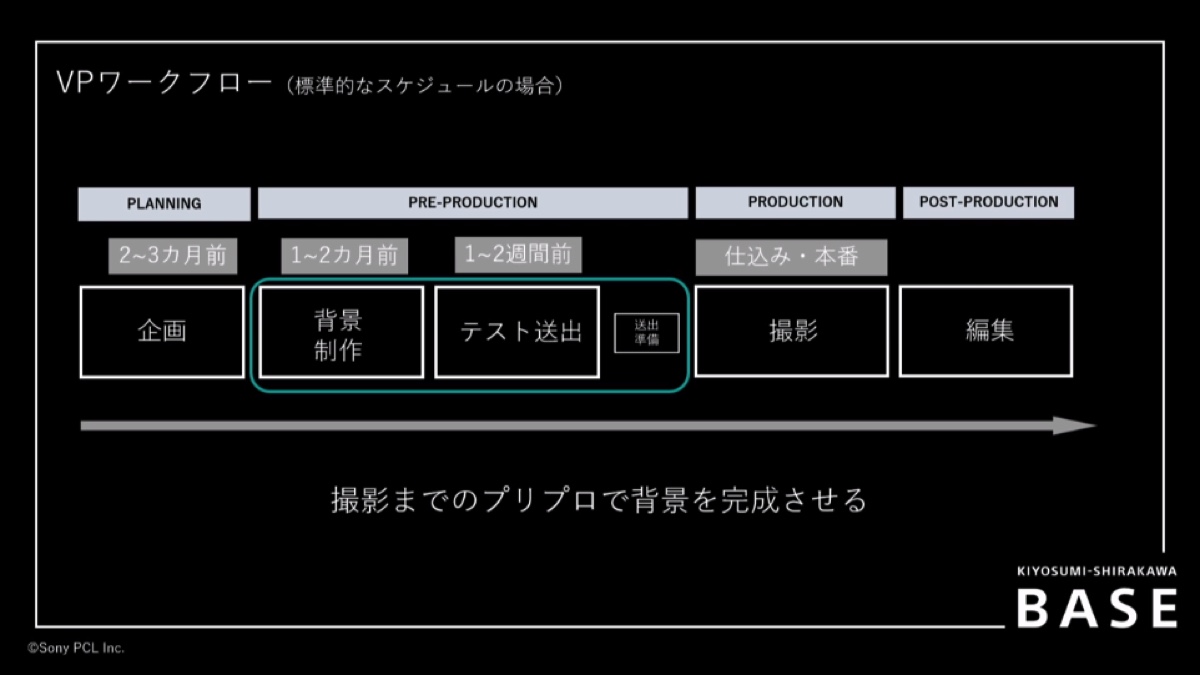

クランクインは2023年の1月だが、ソニーPCLではクランクインの直後からLEDウォールのスタジオを使い出している。その前段階ではアセット(背景などの3D素材)を含めた準備をしていたという。

東映サイドでは最初に5つ、大きなシチュエーションを作ったという。11月ごろからそれらのアセットができあがりはじめ、11月から12月は、毎日ほとんどを検証に費やすこととなった。ソニーPCLにデータを持ち込んだのは12月ギリギリ、もはや年末に近い時期だったと登壇した面々は振り返った。

どうワークフローを確立するか 各組織が連動することで実現したスピード感

東映側では、背景やアセットの最適化にくわえて、撮影の進行について懸念があがっていた。香盤上、転換を含めてある程度は時間がかかる。毎週放送していく中での現場作りで、1日で撮らなければならないシーンが特に多く、どうワークフローを確立するかということだった。

ドラマとしては生の瞬間を切り取ることが多く、物語の進行に合わせて撮影することで芝居も感情が伴ってくる。そのため、インカメラやグリーンバックで撮れるものをまとめて撮って、最後にクロマキー処理をするよりも、できるなら順を追って撮っていきたい。

こうした要望を東映からソニーPCLに渡したが、インカメラやクロマキーの転換にかかる時間が5分〜10分程度であったため、大きな問題にならずに済んだという。バーチャルプロダクションでも時間がネックにならず、ワークフローを大きく変えずに撮影をおこなえたというのは、意外な発見だっただろう。実際、全天球のスクリーンプロセスの素材も4Kから16Kまで出せたため、実写としての説得力もありつつ、短いシーンでも世界観を表現したいときに効果的にセットを使えて、1話分の中の8割9割を一回の撮影で撮ることができた。

照明や美術を始め、東映のチームの転換が速く、その中で背景の調整を合わせるべく、ソニーPCL側も早めに動けるように意識してフローを組むこととなった。

ちょうど本作の撮影タイミングで、360度の全天球素材をそのまま出したり、画像とUEの背景をその場で転換したりと、システムで映し出す映像を切り替える運用が始まったのも幸いだった。この運用を現場で使うのは本作が初めてだったのもあり、転換や映像の出し方、グリーンバックも一部だけにしてアセットの画像そのまま、例えば人物の周りだけグリーンにして、あとは環境光としてインカメラの画像を出すなど、ノウハウを貯めながら対応できたという。

さらに驚くべきは、完成していないアセットを出すなど、多少無理のある要望に対しても、ソニーPCLがペースを合わられた点だ。たとえば、人物の周りだけグリーンにするのも最初からやろうとしていたわけではなかったことのだという。本当ならばありえないワークフローを本番で実験しながらやっていた形だ。

試行錯誤は現場だけでなく、データそのもののリアルタイムな調整にも及んだ。UEのオブジェクトをその場で移動させたり、ステージを回転させてライトを調整するなど、リハーサルやアングルチェックをする中でブラッシュアップしていったのだとか。リハーサルから本番という、ドラマ撮影ならではの流れを切らさぬためには、リアルタイムで調整できるのがカギになる。これは、レンダリングした背景素材とは異なる部分だ。

なので、本作では毎カット、太陽の向きが違う。完全実写で撮影する場合、太陽の位置は決まっているので、それらを勘案しながらアングルや撮影スケジュールを考えることとなる。好きなところに“太陽を置いて”、きれいな影を落とせるのが、UEを使ったバーチャルプロダクションの大きな強みだ。

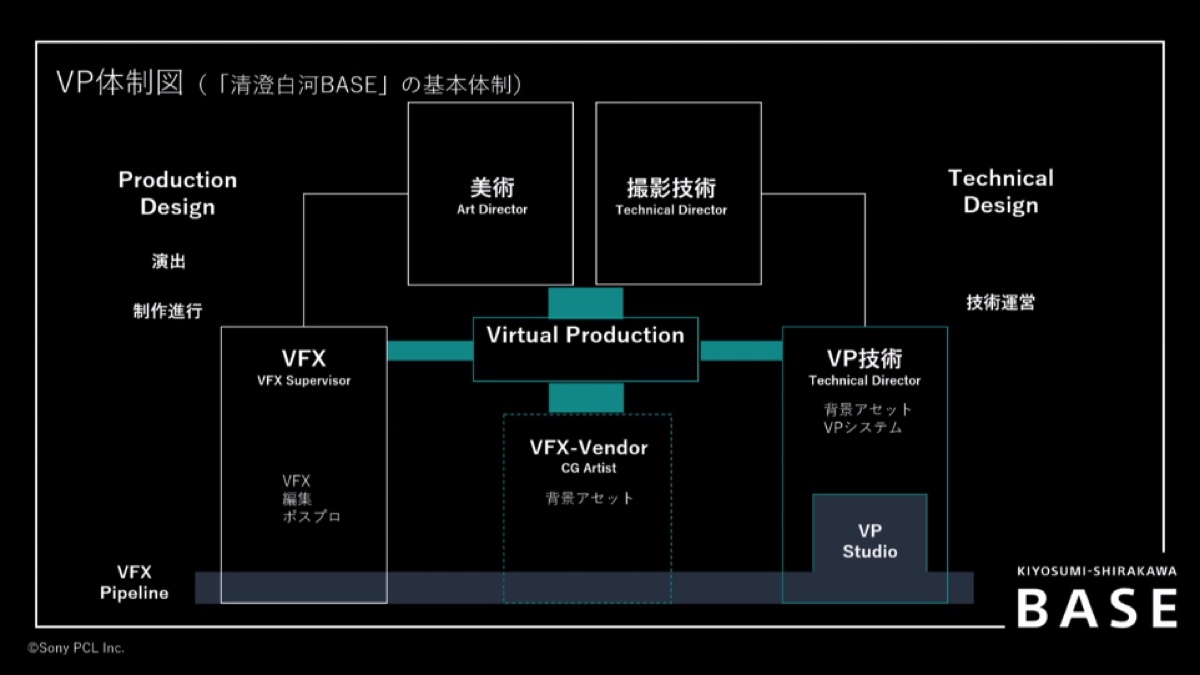

バーチャルプロダクションの体制

撮影現場では、監督自らUEを触ることもあったようだ。珍しいことではあるが、作ろうとしているステージや絵作りを、監督と技術チームが一緒に作り上げることでスムーズな撮影が可能となった。こうした連携も、バーチャルプロダクションを用いた撮影フローにおいては重要だ。

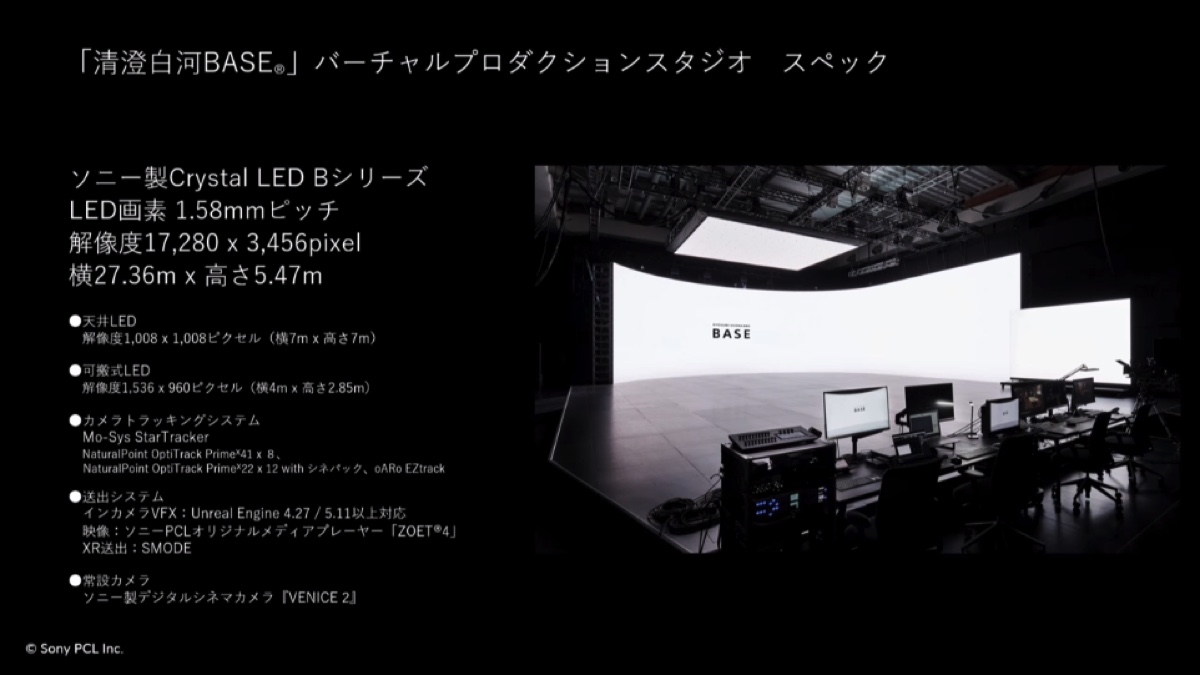

基本的に撮影の日はLEDウォールに背景が出ていなければならず、撮影を迎える前のプリプロダクションに、通常よりも期間が要る。背景を作るときには最低3ヶ月前から準備を始め、テストを踏まえて本番環境へ臨むこととなる。その上で、前述の監督や撮影スタッフを交えた現場での調整など、まさにチーム総出でイメージを共有して制作することが秘訣となる。