空間演出ユニットhuez「3.5次元のライブ演出」第六回

XRライブの鍵は「自由度の取捨選択」? 初音ミク、4s4kiなどのライブ演出事例から考える

ーー嘘くささを修正する細かいテック、というと具体的にはどんな手法がありますか?

そうですね……これはXRライブではなく「バーチャルタレントが現実世界でライブをする」の事例になるんですが、いずれにせよリアルとバーチャルの相互作用が起きるライブではこの嘘くささに気を使う必要があって、例えば7月に行われた『MIKUEXPO』の初音ミクさんの配信ライブ。こちらはflapper3と一緒にやらせていただいたのですが、現実世界の野外会場に生バンドが居て、初音ミク本人だけバーチャルなんです。huezはこのライブで照明をやらせていただいたんですが、夜の野外で、パーライトとかLEDライトとか設置している場所のセンターにミクさんが立っているんですけど……この、現実世界の光が初音ミクさん本体に反映されるんですよ。

――現実世界で照らしている角度を計算して、バーチャル世界にも灯体を置いた、ということですか?

としくに:そうです。バーチャル空間に透明化した灯体を配置して、実際の照明とまったく同じ動きをプログラムしました。照明ってリアルとバーチャルの相互性を保つのにとても重要な要素で、当たってる照明の感じで"生感"が強くなるし、それが反映されていないとすごく映像っぽくなるんですよ。ペタって貼った感じになっちゃう。

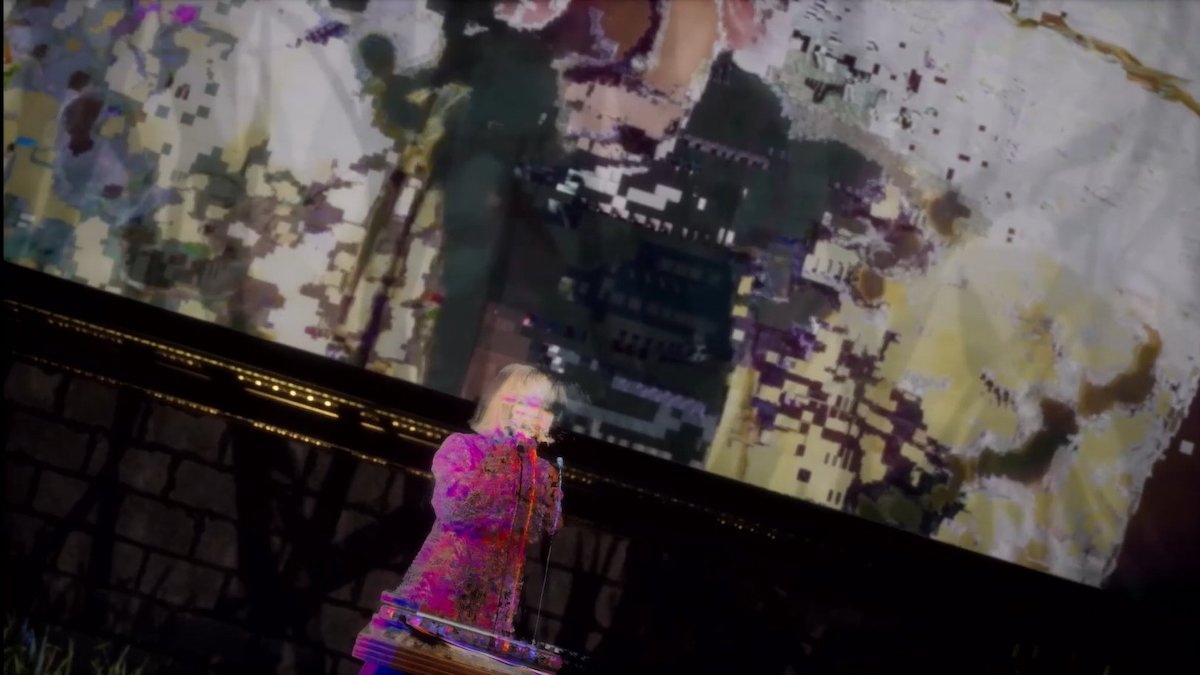

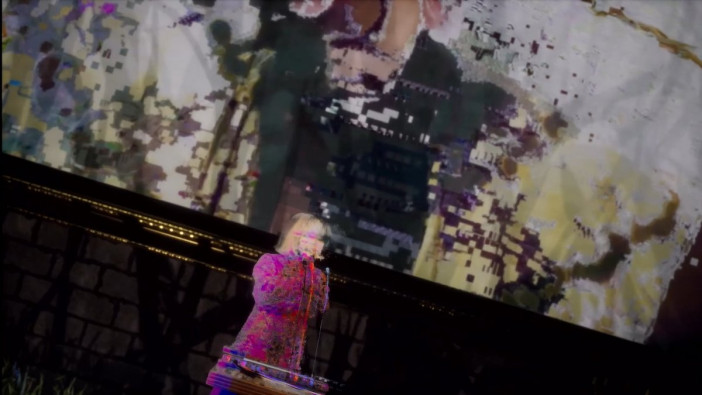

そして、この事例を踏まえた上でお話したいのが、7月に4s4kiさんとhuezがコラボレーションする形でバーチャル空間でのXRライブを演出させてもらった事例です。ここでは先程のミクさんとは逆に、実在の人間にデータ上の照明を当てました。ムービングのライトを本人に当ててる"感じ"を出した。質感が全然変わるんですよね。ペラさが変わる。

ーー実在の人間をバーチャル空間に表す場合、撮影した人物の映像は2Dだと思うんですが、それにバーチャル空間で照明を当てるということは、三次元的な光の当たり方をシミュレートする必要があるかと思うのですが、どうやっているんですか。

としくに:ayafuji君どうやってるの。俺分かってないから。

ayafuji:まずグリーンバックで人物を撮ってバーチャル空間に写すんです。四角いクロマキーの映像がバーチャル空間に現れて、そこに対して照明を当てていくんですが、その映像はおっしゃるとおり2Dなので、言ってしまえば「板」なんですよね。空間に板が浮いて、そこに人が写っているような状態。なので、撮影しているカメラの画角や画質はあらかじめかなり詰めて設定していかなければいけない。写っている画面の画力とバーチャルの全体の画力のバランスみたいなものをなんとなく考えつつ作っていくんです。

その上で、後から板に対して設定できる色々なパラメータがあって。鏡っぽく光を反射させたり、ざらざらした光を反射しない材質だったり、かなり細かいチューニングを施すことができる。そのパラメータをいじりながら、実際のライブで照明が当たったような感じを再現するために調整していく。

――たとえばiPhoneに搭載されているLiDARのように、カメラで3次元的な情報を取れるようなハードウェアもありますが、そういったものは使っていない?

ayafuji:使っていません。単純に"板"としての映像に対してリアルタイムレンダリングで調整をかけていきます。ここに関しては、実際の人が立っている現場の光やその状況と、バーチャル空間の中にあるクロマキーの板をいずれも目で見ながらクオリティを詰めていく。この質感の調整がものすごい大事な要素になっていて、「バーチャルワールドの演出の強さ」と「板(人)の映像のクオリティ」のバランスを取るのがものすごく難しい。さっきとしくにも言っていましたがバーチャルだとなんでもできちゃうので、その世界のリアリティ、を成立させる微妙な塩梅を見つけていかなければいけない。

としくに:そこのバランス調整がクオリティの5割って言っても過言じゃないくらい。

画面の中で、バーチャル空間の中に板のリアルな人間が溶け込むように調整していく。「馴染む」っていう言い方をよくするんですけど、その馴染み方に対して最初にこだわり始めたのが、REZ&さんとかMoment tokyoさんとかなんですよ。

このライブで使ったテックでいうともう一つ、カメラがすごくて。

ayafuji:ソニーのα7S IIIってミラーレス一眼があるんですけど、このカメラにVIVEのトラッカーを付けて、現在の位置とか角度とかを取っているんです。その数字をバーチャル空間のカメラに送ってあげると、撮影されている絵と一緒に背景も傾いていく。それにα7S IIIは超高精細なので、クロマキーの中の人にすごく寄れるんです。バストアップ以上……デコルテのあたりまでグイグイ寄れる。

このセンサーカメラっていう技術はMoment tokyoさんとREZ&さんで作った仕組みで、今、こんなふうにクロマキーを手ブレ込みで出せる仕組み自体があんまりないんです。普通はステージの中にクロマキーの板が浮いているだけなんですけど、S IIIのやつは特別で、もう一枚クロマキーを特別に用意して、それがバーチャルカメラと一緒に動いてるんですよ。

としくに:先程も言いましたが抜いている映像自体は「板」なので、4Kで撮ったとしても寄ったら荒れるんですよ。そうならないように、リアルカメラをバーチャル空間内にアセットしている。

やっている事自体は本当に単純で、カメラにセンサーがくっついてるだけ。で、このセンサーを頑張ってバーチャル空間内でエンジニアチームが同期を取り続けて動かしているんです。

――グリーンバックの前に4s4kiさんが立っていて、それをセンサーの付いたα7 IIIで撮影して、背景をリアルタイムレンダリングしている、ということですか?

としくに:そうです。センサー側で位置をとって、「今カメラが本人の右側に寄った、ということは後ろの背景もちょっとズレるよね」ということをコンピュータで処理している。このカメラでXRライブをやると、本来生ライブでは絶対寄れないレベルまでカメラが寄れるんです。

――なるほど。舞台がないから。

としくに:そう。ステージがないから、生カメラでやってたらカメラマンが映りこんでたような画角でも撮影できる。生のライブしている人間に対してこの距離まで寄った映像ってこれまでないと思います。これができるのってXRライブだけなんですよね。