AGIは10年以内に実現するのか 実現可能性と実存的リスクを考察する

AGIの実現可能性についてAI研究者は「2047年に50%の確率で実現」と回答

AI研究者がAGIの実現可能性についてどのように考えているかに関しては、高度なAIの社会への影響を調査する研究機関・AI Impactsが2024年1月5日に発表した論文にまとめられている。この論文は、2022年のAIに関する世界的カンファレンスに論文が採択されたAI研究者2,778人に対して、AGIの実現可能性などに関するアンケート調査を実施した結果を報告したものだ。その内容の概要は、AI Impacts公開のWikiページで閲覧できる(※5)。

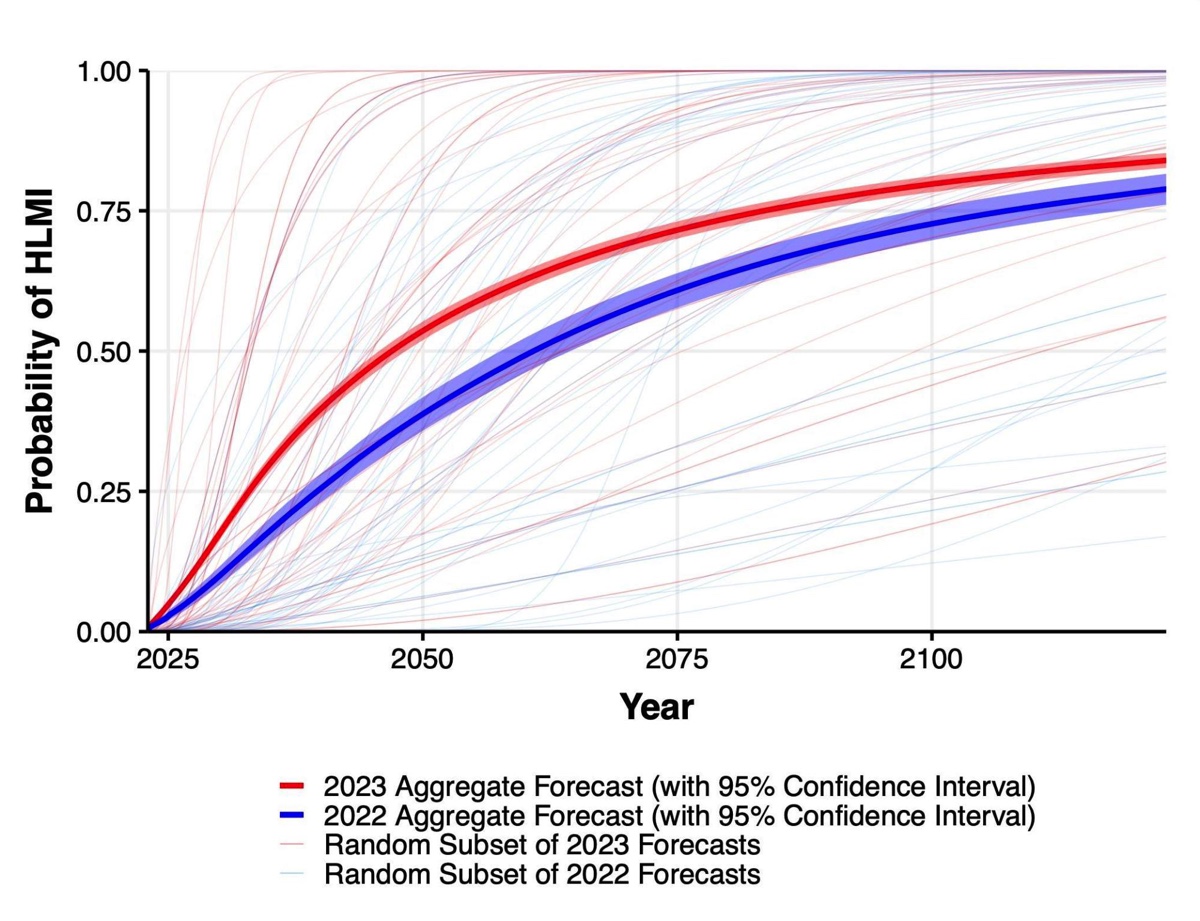

AI Impactsが実施したアンケート調査では、AGIとほぼ同義である「ハイレベル機械知能」の実現可能性に関する設問があった。その質問は、ハイレベル機械知能の実現可能性が時間の推移とともにどのように変化するかを問うものであった。この質問の回答を集計すると、AI研究者は「2047年には50%の確率で実現する」と考えていることが判明した。

同機関は2022年にも同様のアンケート調査を実施していたのだが、2022年の結果と2023年のそれを比較すると、2023年の結果では実現可能性が50%に達する時期が13年早まった。

アンケートでは、AIによる労働の完全自動化の実現可能性についても質問した。その回答の集計結果は「2116年には50%の確率で労働の完全自動化が実現する」というものであった。同様にこの結果を2022年のそれと比較すると、48年早まったことがわかった。もっとも、半世紀近く早まったと言っても、AI研究者は今世紀中に労働の完全自動化が実現する可能性は低いと考えているのだ。

アンケートのなかには、39のタスクに関するAIの実現可能性を問うものもあった。そうしたタスクには「ニューヨークタイムズ紙が出版するようなベストセラー小説を執筆する」や「特定のアーティストに関するフェイクソングを制作する」のようなものがあったのだが、35のタスクが10年以内に実現確率が50%を超えるという回答を得た。この回答は、2022年のそれと比較して平均して1年早まったものとなった。

AI Impactsのアンケート調査にもとづけば、AI研究者は実業界のキーパーソンよりはるかに慎重にAGIの実現可能性を見積もっていることがわかる。しかしながら、同時に2022年の調査と比較すると、AIの進化が加速していると考えていることも明らかになった。

DeepMindが提唱する「AGIのレベル分け」

以上の発言や調査ではAGIの実現時期に言及されていても、それがどのようなプロセスを経て実現されるかについては不明である。こうしたなかGoogleと大規模言語モデル「Gemini」を共同開発したDeepMindは2023年11月、AGIを段階的に実現するためのレベル分けに関する論文を発表した(※6)。このレベル分けは自動運転のレベル分けにインスパイアされており、開発したAIがどのくらい完全なAGIに近づいたかを把握するのに役立つものとなっている。

AGIのレベル分けにおける基本コンセプトは、従来AGIにおける知的能力の幅広さが注目されていたのに対して、その知的能力を人間のそれと比較した場合の「理解の深さ」に着目するというものだ。例えば、幅広い知的タスクにおいて人間の専門家の50%のスキルを実現しているAIは、レベル2の「有能なAGI」に分類される。このように提案されたレベル分けは、人間のスキルと比較したパーセンテージにもとづいて分類される。

このレベル分けにしたがえば、人間の専門家のスキルの99%を実現したAGIはレベル4の「名人AGI」となり、人間を凌駕するものは「超知能」となる。ちなみにChatGPTをはじめとする現在の大規模言語モデルはレベル1の「新興AGI」に分類され、Microsoft Wordのような汎用性がないソフトウェアが属するレベル0よりはAGIに近いと見なされている。AGIのレベル分けを活用すれば、完全なAGIを実現するまでのプロセスをレベルの上昇というわかりやすいイベントによって把握できるようになる。

こうしたなか、株式会社WEELは2024年1月25日、このレベル分けにインスパイアされた「AGI終末時計」をリリースした(※7)。

これはAGIのレベル分けと世界の滅亡までの残り時間を可視化する世界終末時計を組み合わせたものであり、2024年2月時点では2027年にレベル4のAGIが実現すると仮定した場合の残り時間を表示している。2027年にAGIが実現するという仮定については議論の余地があるものも、AGI終末時計はAGIの実現に注意を向けさせるという点で興味深い試みであろう。

「ペーパークリップ最大化知能」から見る実存的リスク

AGIの実現に関連して再三問われるのが、そのような高度なAIが人類に敵対する可能性である。こうしたAIが人類を滅ぼすようなリスクは、偽情報の流布のような既知のリスクと区別して“実存的リスク”と呼ばれる。

人間を凌駕する超知能とその実存的リスクは、哲学者のニック・ボストロム氏が2014年に発表した『スーパーインテリジェンス: 超絶AIと人類の命運』(邦訳は2017年出版)で詳細に分析されることで世間に知られることとなった。2023年8月には、同氏のインタビュー記事がクーリエ・ジャポンに掲載された(※8)。このインタビューで、同氏は実存的リスクについて改めて語っている。

実存的リスクを語るにあたって、ボストロム氏は有名な「ペーパークリップ最大化知能」に言及した。これは、ある超知能がペーパークリップを可能なかぎり大量に製造するように命令された場合の結末に関する思考実験である。超知能は自分が宇宙を支配できれば、ペーパークリップ製造を止める者はいなくなると考えるかも知れない。そして、実際にそのように考えると、ペーパークリップ製造を邪魔するかも知れない人間をせん滅する可能性があるのだ。

ペーパークリップ最大化知能から得られる教訓は、高度なAIは人類を滅ぼそうとする“積極的な悪意”がなくとも人類を滅ぼすリスクがある、ということである。こうしたリスクを回避するには、AIが人間の価値観と相容れない判断をくださないように開発することが不可欠となる。こうした開発思想は、「AIアライメント」と呼ばれる。

実のところ、AIアライメントはすでにChatGPTの開発で活用されている。同AIは、前身モデルにあたるGPT-3.5を人間にとって好ましい回答を出力するように訓練したことで誕生したのだ。訓練にあたっては、人間の作業者が回答の好ましさを評価した。こうした訓練のおかげで、ChatGPTは人間が親しみやすい対話型AIとなったのだ。

本稿では「AGIの実現可能性とリスク」について考察してきたが、いまの時点ではAGIが2~3年以内に実現する可能性はなさそうだと言える。しかしながら、AI業界はAGIの実現に向かって歩み出しており、その実現に接近するにつれてリスクも高まることだろう。安全かつ安心にAGIを実現するためには、社会全体がAGIに関心を持ち続けながら、リスクが高まる度に適切に対処・判断すること求められる。

〈参考資料〉

(※1)OpenAI「Planning for AGI and beyond」

(※2)OpenAI「Weak-to-strong generalization」

(※3)SoftBank「AIは『AGI』へと進化し、今後10年で全人類の叡智の10倍を超える。孫正義 特別講演レポート」

(※4)Threads:https://www.threads.net/@zuck/post/C2QBoRaRmR1

(※5)AI Impacts「2023 Expert Survey on Progress in AI」

(※6)Google DeepMind「Levels of AGI: Operationalizing Progress on the Path to AGI」

(※7)PR TIMES「AGIの到来をカウントする『AGI終末時計』を、月間100万PV超え生成AI専門メディアがリリース」

(※8)クーリエ・ジャポン「ニック・ボストロム『意識を持っていようといまいと、AIが人類を滅ぼす危険性はある』」

GoogleとOpenAIの争いは激化必至か 2024年注目の生成AIトレンド4項目

2023年は生成AIが飛躍的に普及した年であり、特にOpenAIの「ChatGPT」が市場をけん引する形で広まりを見せた。本稿で…