『Vision Pro』の発表からAppleのモノづくり戦略を読み解く(インターフェイス編) 歴代製品に共通する“掛け算のうまさ”

加速度モニタリングとジェスチャーの検知

前述のとおり、Vision Proには「コントローラー」が存在しない。しかし、Vision Proは使用者の「手の動き(ジェスチャー)」を認識する。こうした機構はどのように実現しているのだろうか?

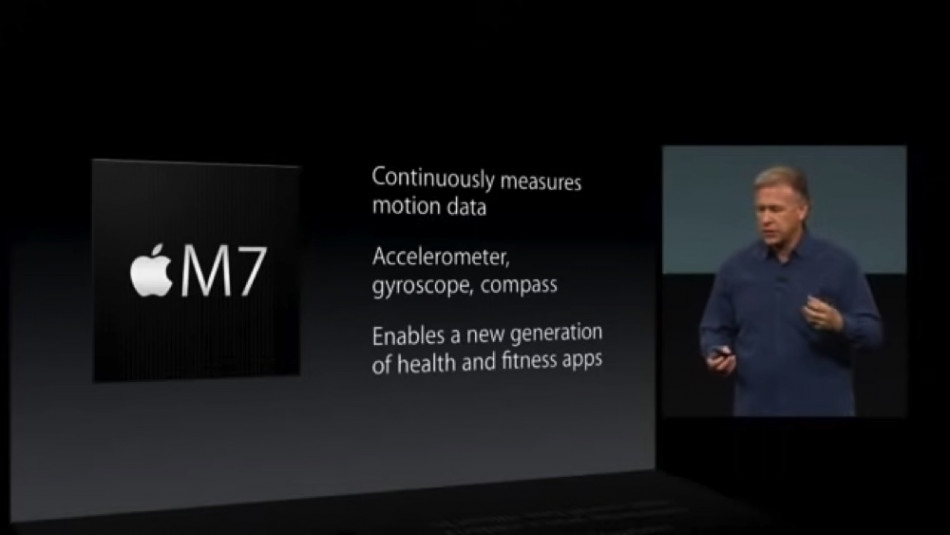

参考になるのは2013年に発表された『iPhone 5s』だ。iPhone 5sには従来機同様に、加速度センサー、ジャイロスコープ、コンパスなどが搭載されていたが、これに加えて「M7」というコプロセッサーが採用された。各種センサーが収集したモーションデータにまつわるタスクは従来機では「Aシリーズ」のプロセッサーが行っていたのだが、これらの処理を独立したコプロセッサーに割り当てることで省電力と常時起動を両立した。これにより、iPhoneは「ユーザーが今、歩いているのか、走っているのか、あるいは自転車・自動車に乗っているのか」を理解できるようになった。

翌年の2014年に発表された『iPhone 6』には気圧計も搭載され、上下の動き(たとえば「階段の上り下り」)なども検知できるようになった。Vision Proのプレゼンを見ると、座ったり立ったり、リビングで使ったり会社で使ったりと、使用時における「移動」の不自由がないことは強くアピールされており、これを実現する技術の発端もまたiPhoneであることに疑いの余地はない。

また、人の動きをトラッキングする取り組みにおいて『Apple Watch』から得られた知見は大いにあるだろう。特に、Apple Watchの「AssistiveTouch」という機能は、Apple Watchを片手のジェスチャーだけで操作することを可能にするもの。AssistiveTouchという機能自体はiPhoneなどにもあり、既存の操作をジェスチャーやタップに置き換えるものだが、Apple WatchのAssistiveTouchは操作系の置き換え方が秀逸で、指の動きや手の握り込みなどを検知する。WWDCの動画に映るVision Proの操作シーンは、Apple WatchでAssistiveTouchを使う様子と非常に近い。

- 出典:https://www.youtube.com/watch?v=8Dta84LUi20

- 出典:https://www.youtube.com/watch?v=GYkq9Rgoj8E

人物認識と瞳トラッキング

Vision Proのリリースによれば、瞳の虹彩を認識するセキュリティ機構「Optic ID」が搭載されるようだ。こうした人の身体を記憶して認識する機構において、Appleは様々な技術を持っている。前述の「Hey Siri」のパーソナライズはもちろん、「Touch ID」や「Face ID」などもこれに含まれるだろう。

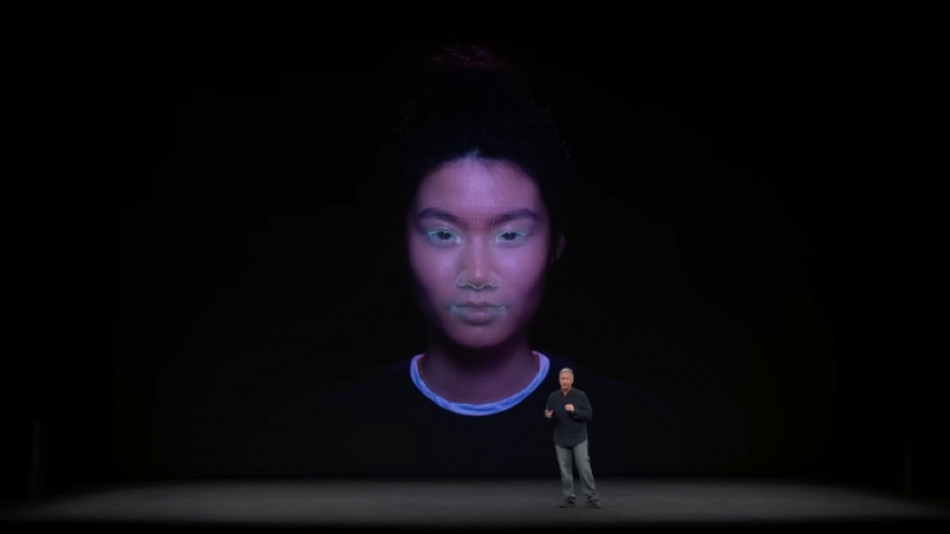

Face IDはTouch IDに代わるiPhoneのセキュリティ機構として、2017年に発表された『iPhone X』から導入された。搭載されたプロセッサー「A11」に採用された「TrueDepthテクノロジー」によって実現している機能だ。AppleによればTrueDepthカメラは「何千もの目に見えないドットを顔の上に投射して解析し、顔の深度マップを作成して、顔の正確なデータを読み取ります」という。

これはFace IDの基幹技術であり、Face IDには「画面注視認識機能」も備わる。つまりiPhoneは「ユーザーがiPhoneを見ていること」を検知できるのだ。Face IDは先進のニューラルネットワークによってなりすましへの対策が取られているとその堅牢性が語られているが、この機能が示すところは、Appleは世界中のユーザーの顔面の深度情報を持っており、こうした情報と機械学習の組み合わせでセキュリティ機能を実現しているということだ。

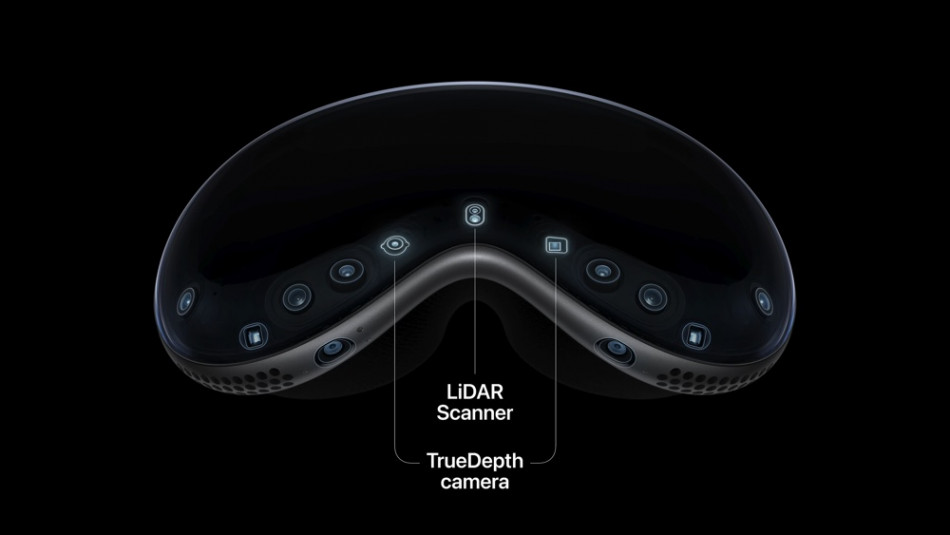

ちなみにこの「深度情報で動きや距離を検知する」というアプローチは発展しており、後にiPhoneは2020年に発表した『iPhone 12 Pro・Pro Max』に「LiDARセンサー(Light Detection and Rangingセンサー:光検出と測距用のセンサー)」を搭載し、対象までの距離や性質をより正確に検知できるようになった。

LiDARセンサーの恩恵としてわかりやすい例をひとつ挙げると、iPhoneの「写真」アプリのポートレートモードがそれだ。これは「写真のボケ感をコントロールできる機能」で、このボケ感の設定にはLiDARセンサーの深度情報が活用されている。そしてVision Proは「TrueDepthカメラ」と「LiDARセンサー」のいずれもを搭載する。センサーの位置から推察するに、手のジェスチャーなどを検知する役割もあるのではないだろうか。

さて、ここまで既存のAppleのテクノロジーと、発表で紹介されたVision Proの断片を照らし合わせてみるというアプローチで、Vision Proのインターフェースについて読み解いてきた。ここで明らかにしたかったのは、Appleのモノづくりが「製品ジャンルを超えた“技術のかけあわせ”による相互の発展」によって実現しているということだ。今回はインターフェース(操作系)に絞った形でその採用技術を解説したが、次回は少し趣を変え、ハードウェア・ソフトウェアのそれぞれについて、同じアプローチで探ってみたいと思う。