AI×エンタメの“現在地と未来”

「データ分布の外側」にある音楽へたどり着くためにーーQosmo徳井直生&アンドリュー・ファイフに聞く“AI×音楽研究の現在地”

1984年に世界初のサンプリング・シンセサイザー『Kurzweil K250』が発売された。この機材にはすでに人工知能が搭載されており、その学習手法はいまでいう「ディープ・ラーニング」と同じ考え方を持つ。開発者はなんと「シンギュラリティ」を唱え、GoogleでAI開発に携わったレイモンド・カーツワイル博士。さらに製作を要請したのは彼の技術に目を付けたスティーヴィー・ワンダーだった。

日本人ミュージシャンたちからは「カーツウィル」と呼称されるために、カーツワイル博士との接点は見落とされがちだが、音楽テクノロジーはAI技術の黎明期からリンクを持つ。そして現在、画像における『Stable Diffusion』や対話型AI『ChatGPT』が世間を騒がせ、なかでも生成系AIの波は音楽にも押し寄せている。近い将来、与えられたキーワード通りの音楽が数秒で生み出せる時代になるかもしれない。

そして、その分野に早くから取り組み、開発を進めてきた日本人がいる。現在は自身が運営する株式会社QosmoでAIオーディオ・プラグイン『Neutone』を手がける徳井直生氏だ。

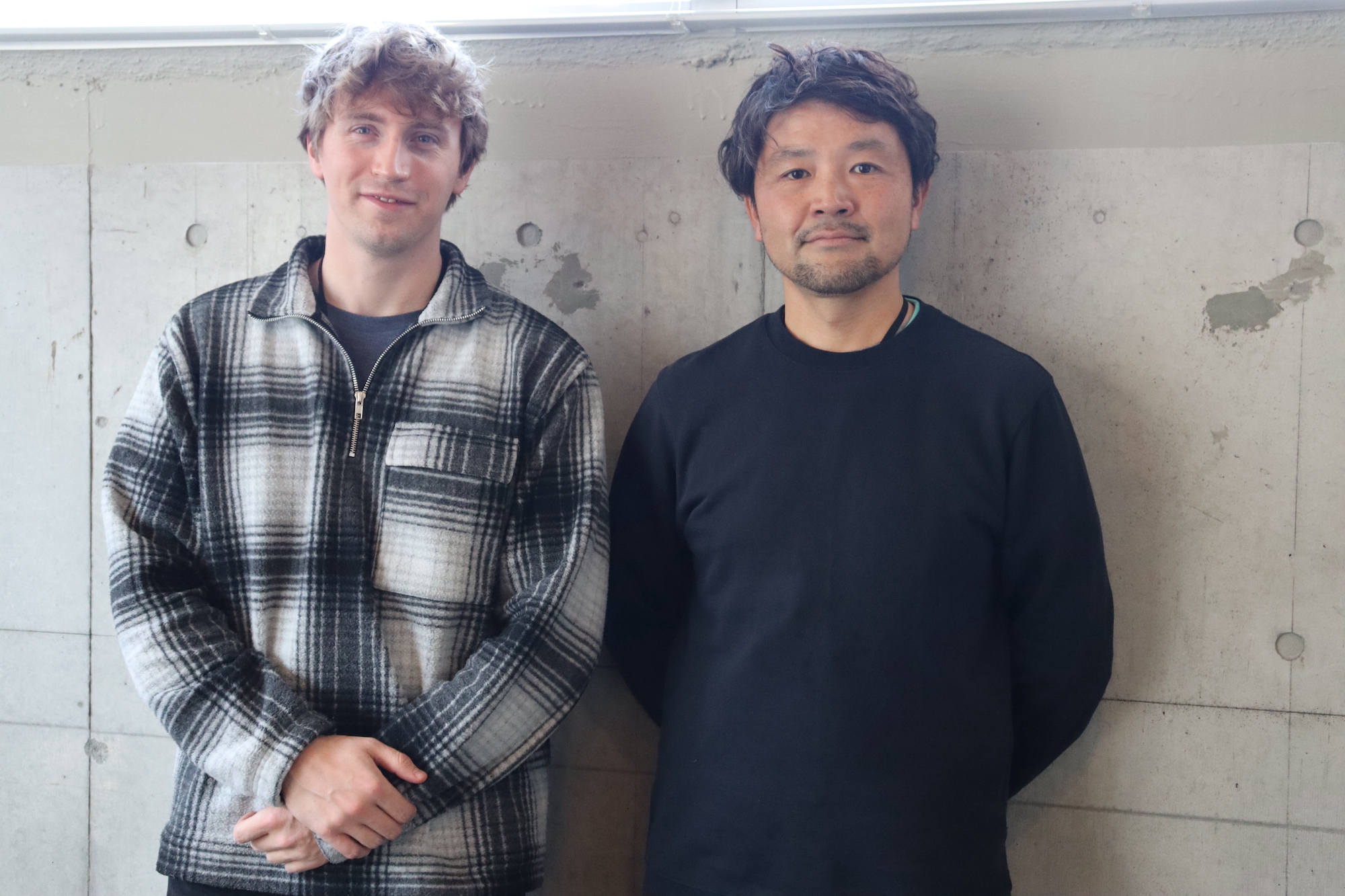

生成系AIのなかでも、比較的好意的に取り入れられ、さまざまな機能・サービスの芽が出始めている音楽生成AI。開発視点から見た現状はどうなっているのだろうか。徳井氏と、Qosmoの開発チームのメンバーであるAndrew Fyfe(アンドリュー・ファイフ)氏にAI技術の音楽的な現状やプラグイン開発の実情などを聞いた。(小池直也)

「連載:AI×エンタメの“現在地と未来”」バックナンバーはこちら

「ミュージシャンはバグですら面白がる」 研究者との認識のズレが生んだ『Neutone』

――徳井さんは、研究者であると同時にミュージシャンでもありますね? Nujabes氏とともに「Urbanforest」としてユニット活動をされていた過去もあるとか。

徳井:そうですね。研究者とミュージシャンの2足の草鞋です。大学院でAIの研究をやっていたときーーといっても当時はいまと比べると稚拙な技術でしたが、アルゴリズムを使った音楽を、Nujabesと一緒に作っていました。いわゆる“Nujabesっぽさ”からは外れた実験的な内容で、毎週水曜日の午後に彼のスタジオに行き、そこで作業して夜は飲みに行くという生活を2年くらい続けていたんです。結果、実験ばかりで曲が増えず1曲しかリリースできませんでした(笑)。彼のHDDには発表してないデータがあるはずですが……。

――過去のインタビューを見ると、ふたりで『CYCLING'74 Max/MSP』のパッチを使ってディレイの開発をしていたとか。

徳井:ヘンテコなディレイを作ったりしてましたね。プログラミング言語「Max」を使って、サンプリングした音を、ディレイを使って変則的なリズムで並べるようなものを開発していたんですよ。

――当時から「AI」というトピックがあったんですか?

徳井:2000年頃のことですが、当時からありましたね。それから2009年に株式会社Qosmoを立ち上げたんですが、当時はまだAI関連の仕事はなくって、企業向けのインスタレーションを作ったり、iPhoneのアプリを開発したりと色々やっていました。

その後、「ディープラーニング」の技術が2012年頃から盛り上がり、それが使いやすい形になって、さらに音楽に応用する動きも出てきました。それで、2015年頃からは再びAIが面白くなってきて、Qosmoでも「AI」と「音楽」を掛け合わせた仕事が増えていったんです。巡り巡って本来やりたかった「AIの創作分野における活用」という分野で少しづつお金が回り始めたんですね。

――徳井さんは以前、Noteに「2022年には『DALL-E』や『Stable Diffusion』のような画像生成AIモデル、『ChatGPT』などの陰に隠れて、『RAVE』や『MUSIKA』などのAIを用いたリアルタイムの音楽のための音響合成技術が現れた年だった」と書かれています。こちらの記述について、印象に残っていることを教えてください。

〈参考:「Making of "Emergent Rhythm" — リアルタイムAI音響合成を用いたライブ・パフォーマンスの裏側」〉

徳井:2018年~2019年ごろはまだAIでMIDIや楽譜の生成をしていて、それをソフトウェア・シンセなどで音に変換する必要がありました。しかし、2020年からは音をAIで直接生成できるようになってきたんです。

すると、今度は『Google Home』の音声合成に使われていた技術が音楽にも使われだして、2022年にはリアルタイムで音を生成するところまで至りました。それがブレイクスルーでしたね。こうなる流れは我々も見えていて、2020年の終わりごろに、リアルタイムのオーディオ処理に対応した『Neutone』の開発をスタートしました。

――世間で注目され始める前から、まさにアーリーアダプターとして動いていたからこその読みですね。Qosmoとして、今後はどのような方針をとっていくんでしょう?

徳井:今年は音楽にとって、まさに画像生成における「Stable Diffusion」が登場した時のような状況になっていますよね。今後は、Googleが開発した歌った音にMIDIではなく音として伴奏を付けてくれるAI『SingSong』など最新技術のリサーチをフォローアップしながら、自分たちも使えそうなモデルや独自に開発するところまで手を付けていければと考えています。

――そうした状況の中で、早くからAIと音楽の領域に投じて誕生したのが『Neutone』というわけですか……。改めて『Neutone』の意義についてもお聞かせください。

徳井:AIと音楽という分野において僕が問題だと思ったのは、前述したような新たな技術やその情報が、研究者の分野内で閉じてしまっていて、ミュージシャン自らプログラミングができないと使えないことでした。そして、研究者はミュージシャン目線であまり考えられないこともそうです。

研究者が学習データをどう正確かつ効率的にAIで再生成できるかを考えがちなのに対して、ミュージシャンはバグですら面白がることもあるじゃないですか。そのギャップに気付いて、先端のAIモデルをミュージシャンたちが普段使っているAbleton『Live』や『Logic』などのDAWソフトで気軽に使えたら、という妄想を形にしたのが『Neutone』でした。

――なるほど。

徳井:例えば「Python」上でパラメータを与えたら30秒の曲が瞬時に生成されるモデルがあります。それ以前は、同じ尺を生成しようとしたら1時間、1日と長い時間を要したので、段々とリアルタイムになってきました。

けれども本質的には、ミュージシャンは別に30秒の完成した曲を求めているわけではないんです。パラメータを変えたら、すぐにリアクションする、自分が曲作りに使える要素を提供してくれるシステムがほしいんですよ。だからこそ、我々は既存のモデルやAIの仕組みをよりインタラクティブに使うためにモデルの改編や改良に取り組んでいます。

研究者からしても、作ったものをなるべく早くミュージシャンに渡した方がフィードバックが早く返ってきて、研究においてもメリットがあると思うんですよ。

――「妄想を形に」とおっしゃられましたが、具体的にどのように開発を進めていったんでしょう?

徳井:開発は具体的に大きく分けてAIのパートとプラグインのパートがあります。前者が研究レベルのモデルをミュージシャン向けにカスタムする作業で、後者は伝統的なオーディオ・プラグインの作り方に近いです。前者は「Python」、後者は「C++」なのですが、まあ両方を器用に使える人はなかなかいなくて(笑)。そんな時に出会ったのがアンドリューでした。

アンドリュー:僕は徳井さんがリリースした「Max」のプラグインを見てQosmoを知りました。僕自身、博士課程の学生でもあり「どうやったらAIを音楽分野で創造的に使えるか」ということをテーマに研究をしています。

徳井:彼はオーディオ・プラグインの会社にいた経験もあるので「C++」も書けるんです。最初はインターンとしてリモートで開発に関わってもらい、共に設計を練っていきました。現在、Neutoneの開発チームはUK、カナダ、ルーマニア、アメリカなど、国際色豊かなチームになっていますよ。