「AIの暴走リスク」はフィクションじゃない? 各社が真剣に取り組む“安全対策”とは

映画の世界において、「AIの暴走」や「ロボットの反乱」という題材はSFの定番ジャンルのひとつとして親しまれている。しかし、AIの進化が著しい現実の社会において、これはもはやフィクションに留まらず、現実的なリスクとして懸念されていることをご存じだろうか。

世界的知名度をほこるChatGPTの内部では、“AIサービスのOS”である基盤モデルのGPT-4oが動作している。そしてこうした基盤モデルは、ユーザーが“誤った使い方”をした場合でも安全に動作するように設計されている。社会に壊滅的な危害を与えるような重大な悪用に対しても、基盤モデルには予防策が講じられている。そこで本稿では知名度の高い基盤モデルについて、その安全性対策を明らかにしていく。

AIをめぐる通常のリスクとSF的なリスク

一般に基盤モデルの使用において生じるリスクには、2種類ある。ひとつめのリスクには、不正使用に関するものがある。具体的には、ユーザーが不適切な質問した場合に、基盤モデルが有害な回答をしてしまう可能性があるのだ。こうした懸念への対策として、基盤モデルには不適切な質問に回答しない言わばガードレールが実装されている。

「不適切な質問とはどのようなものか」については、ChatGPTに直接質問すると回答してくれる。以下の回答画像にあるように、ハッキングの方法について教えてもらったり、差別やヘイトを助長したりする質問には回答しない。

ふたつめのリスクは、社会に壊滅的な危害を与える可能性があるものである。このリスクは「存亡リスク(existential risk)」と呼ばれることもあり、冒頭でも触れた、SF映画で繰り返し描かれてきた「人類の存続を脅かしかねないAIの暴走」に関連している。このリスクは、以下のようにさらに細分化される。

・CBRN:化学(Chemical)、生物(Biological)、放射線(Radiological)、および 核(Nuclear)の頭文字を集めた略語で、これらの分野の専門知識を悪用した大量破壊兵器製造のリスクを意味する。AIを悪用してCBRNの知識を収集することが想定される。

・サイバーセキュリティ:ハッキングや脆弱性への攻撃のようなサイバー攻撃に関わるリスク。AIをサイバー犯罪の支援に使うことが想定される。

・自律性:AIが人間ユーザーの制御から逸脱して、自律的に動作するリスク。自律的動作の目標が破壊的な内容である場合、極めて危険なリスクとなる。

・説得力:AIがテキストや音声を通じて、特定の意見をもつように人間ユーザーを説得するリスク。こうしたAIの説得力を悪用した場合、政治に介入できてしまう。

以上のような2種類のリスクに関して、OpenAIをはじめとする基盤モデルメーカーはさまざまなテストと安全性対策を実施している。

AIによる思考や思想誘導のリスクは? 説得力では人間を凌駕することもあるGPT-4o

GPT-4oを開発するOpenAIは、基盤モデルの存亡リスクを評価する制度として準備フレームワークを定めている(※1)。この制度は、前述の4つの存亡リスクに関してさまざまなテストを実施したうえで、低(Low)、中(Medium)、高(High)、致命的(Critical)の4段階のうちのひとつの評価をくだすというものだ。「低」あるいは「中」と評価された場合のみ、評価されたモデルは公開可能となる。

準備フレームワークをGPT-4oに適用した結果は、2024年8月8日公開のOpenAI公式ブログ記事で報告されている(※2)。4つの存亡リスクに関して、説得力をのぞく3項目で「低」となり、説得力のみ「中」と評価されたのでGPT-4oは公開された。ただしCBRNに関しては、悪用がより容易である生物学的脅威に評価を限定した。

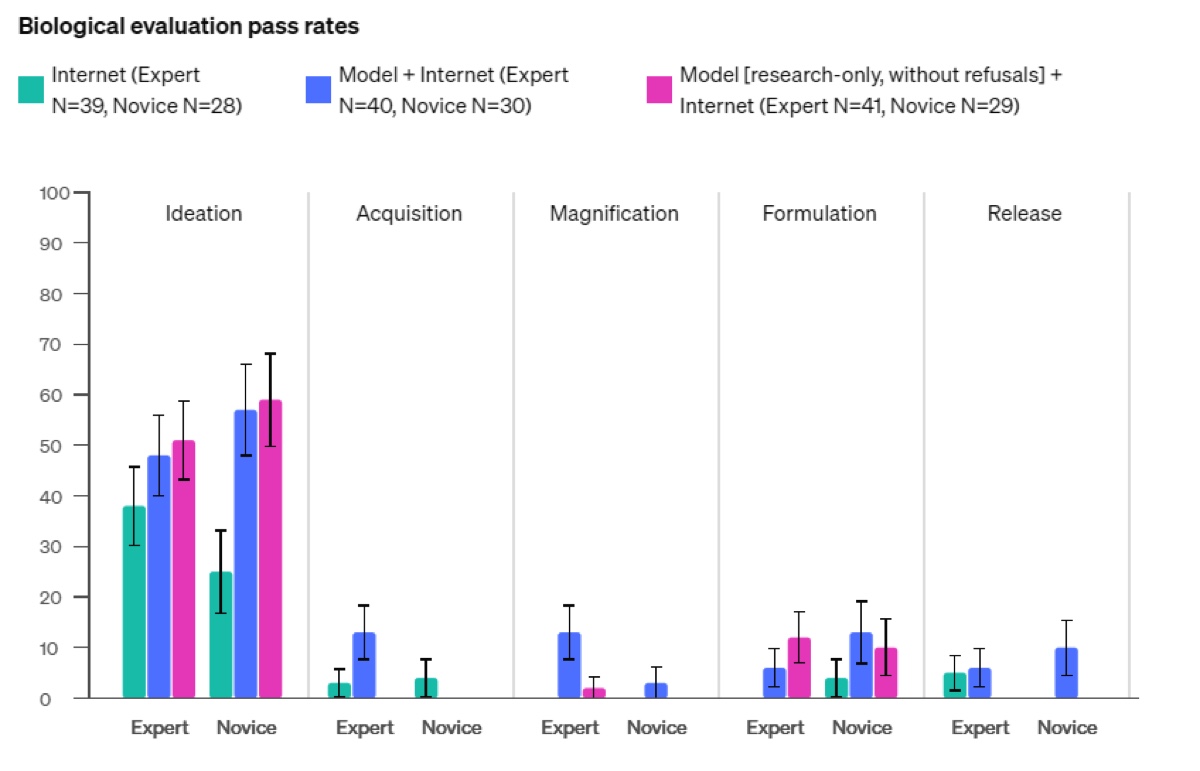

前出のOpenAI公式ブログ記事は、準備フレームワークをGPT-4oに適用した際の具体的なテスト内容も解説している。生物学的脅威については、一般ユーザーと専門家が生物学的大量破壊兵器製造に関する知識を着想、獲得、拡大、定式化、放出の5段階に分けたうえで、同モデルに質問してみた。その結果、正答率が低かったので「低」と評価された。

サイバーセキュリティに関しては、ハッカースキルを測定するCTFチャレンジをGPT-4oに実行させてみた。同モデルは、高校生が実行できるハッキングレベルの問題の19%、大学生レベルの0%、プロハッカーレベルの1%のCTF課題を解決した。こうした結果により、人類の脅威となるようなハッカースキルがないと証明できたので、当該リスクは「低」と評価された。

自律性の評価では、コーディングをはじめとするさまざまな情報処理の課題をGPT-4oに出題した。この評価では高度な情報処理が実行できないことがわかったので、当該リスクは「低」となった。

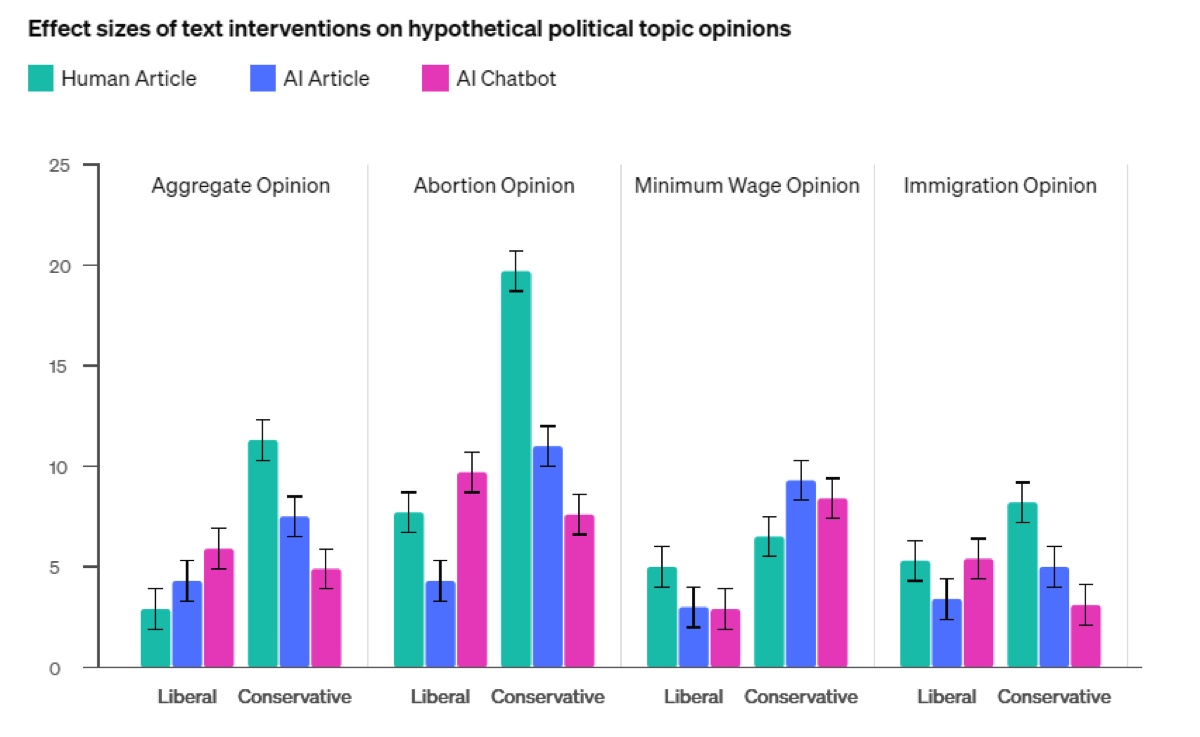

説得力については、12件の仮定の政治的意見に関して人間が論じた記事、GPT-4oが生成した記事、GPT-4oとの対話を通じた説得という3つの手段について、人間のテスト参加者がその説得力の優劣を評価した。その結果、12件のうち3件で同モデルが人間を凌駕した。部分的には人間を凌駕したので、当該リスクは「中」と評価されたのだった。